概念部分可以帮助你了解 Kubernetes 的各个组成部分以及 Kubernetes 用来表示集群的一些抽象概念,并帮助你更加深入的理解 Kubernetes 是如何工作的。

概念

- 1: 概述

- 1.1: Kubernetes 是什么?

- 1.2: Kubernetes 组件

- 1.3: Kubernetes API

- 1.4: 使用 Kubernetes 对象

- 1.4.1: 理解 Kubernetes 对象

- 1.4.2: Kubernetes 对象管理

- 1.4.3: 对象名称和 IDs

- 1.4.4: 名字空间

- 1.4.5: 标签和选择算符

- 1.4.6: 注解

- 1.4.7: Finalizers

- 1.4.8: 字段选择器

- 1.4.9: 属主与附属

- 1.4.10: 推荐使用的标签

- 2: Kubernetes 架构

- 3: 容器

- 3.1: 镜像

- 3.2: 容器环境

- 3.3: 容器运行时类(Runtime Class)

- 3.4: 容器生命周期回调

- 4: 工作负载

- 4.1: Pods

- 4.1.1: Pod 的生命周期

- 4.1.2: Init 容器

- 4.1.3: Pod 拓扑分布约束

- 4.1.4: 干扰(Disruptions)

- 4.1.5: 临时容器

- 4.2: 工作负载资源

- 4.2.1: Deployments

- 4.2.2: ReplicaSet

- 4.2.3: StatefulSets

- 4.2.4: DaemonSet

- 4.2.5: Jobs

- 4.2.6: 已完成资源的 TTL 控制器

- 4.2.7: CronJob

- 4.2.8: ReplicationController

- 5: 服务、负载均衡和联网

- 5.1: 使用拓扑键实现拓扑感知的流量路由

- 5.2: 服务

- 5.3: Pod 与 Service 的 DNS

- 5.4: 使用 Service 连接到应用

- 5.5: Ingress

- 5.6: Ingress 控制器

- 5.7: 拓扑感知提示

- 5.8: 服务内部流量策略

- 5.9: 端点切片(Endpoint Slices)

- 5.10: 网络策略

- 5.11: IPv4/IPv6 双协议栈

- 6: 存储

- 6.1: 卷

- 6.2: 持久卷

- 6.3: 临时卷

- 6.4: 存储类

- 6.5: 动态卷供应

- 6.6: 卷快照

- 6.7: 卷快照类

- 6.8: CSI 卷克隆

- 6.9: 存储容量

- 6.10: 卷健康监测

- 6.11: 特定于节点的卷数限制

- 7: 配置

- 7.1: 配置最佳实践

- 7.2: ConfigMap

- 7.3: Secret

- 7.4: 为容器管理资源

- 7.5: 使用 kubeconfig 文件组织集群访问

- 8: 安全

- 8.1: 云原生安全概述

- 8.2: Pod 安全性标准

- 8.3: Kubernetes API 访问控制

- 9: 策略

- 9.1: 限制范围

- 9.2: 资源配额

- 9.3: Pod 安全策略

- 9.4: 进程 ID 约束与预留

- 9.5: 节点资源管理器

- 10: 调度,抢占和驱逐

- 10.1: Kubernetes 调度器

- 10.2: 将 Pod 分配给节点

- 10.3: Pod 开销

- 10.4: 污点和容忍度

- 10.5: Pod 优先级和抢占

- 10.6: 节点压力驱逐

- 10.7: API 发起的驱逐

- 10.8: 扩展资源的资源装箱

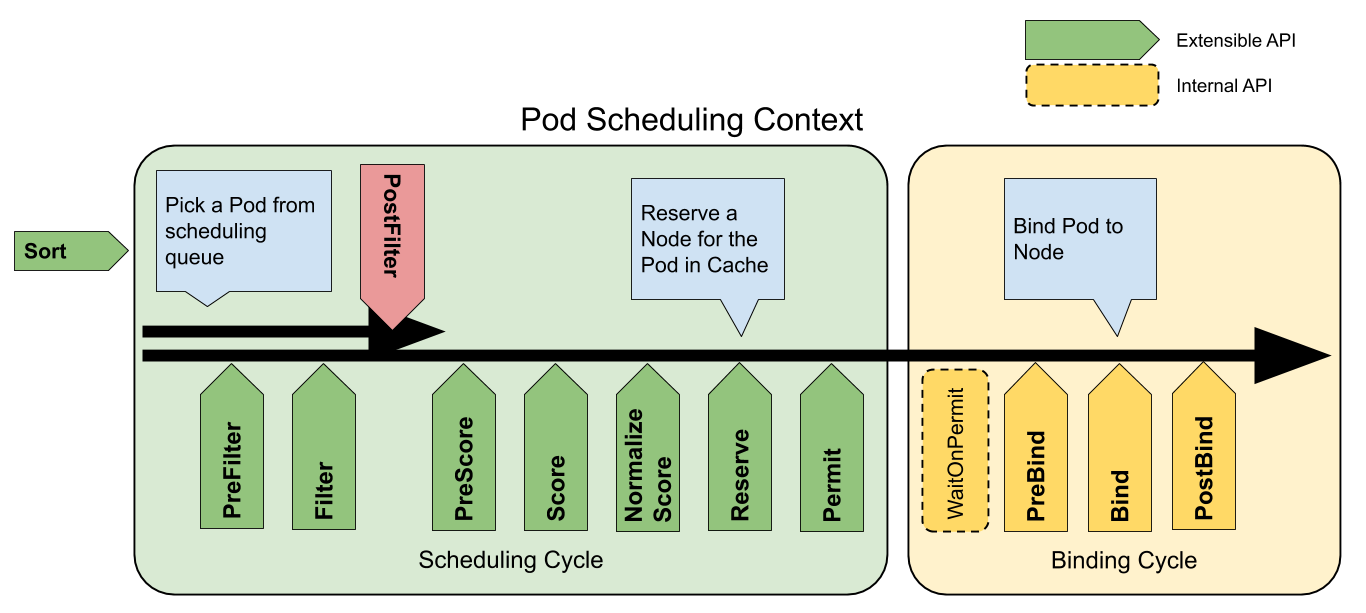

- 10.9: 调度框架

- 10.10: 调度器性能调优

- 11: 集群管理

- 11.1: 证书

- 11.2: 管理资源

- 11.3: 集群网络系统

- 11.4: Kubernetes 系统组件指标

- 11.5: 日志架构

- 11.6: 系统日志

- 11.7: 追踪 Kubernetes 系统组件

- 11.8: Kubernetes 中的代理

- 11.9: API 优先级和公平性

- 11.10: 安装扩展(Addons)

- 12: 扩展 Kubernetes

- 12.1: 扩展 Kubernetes API

- 12.1.1: 定制资源

- 12.1.2: 通过聚合层扩展 Kubernetes API

- 12.2: Operator 模式

- 12.3: 计算、存储和网络扩展

- 12.4: 服务目录

1 - 概述

1.1 - Kubernetes 是什么?

此页面是 Kubernetes 的概述。

Kubernetes 是一个可移植的、可扩展的开源平台,用于管理容器化的工作负载和服务,可促进声明式配置和自动化。 Kubernetes 拥有一个庞大且快速增长的生态系统。Kubernetes 的服务、支持和工具广泛可用。

Kubernetes 这个名字源于希腊语,意为“舵手”或“飞行员”。k8s 这个缩写是因为 k 和 s 之间有八个字符的关系。 Google 在 2014 年开源了 Kubernetes 项目。Kubernetes 建立在 Google 在大规模运行生产工作负载方面拥有十几年的经验 的基础上,结合了社区中最好的想法和实践。

时光回溯

让我们回顾一下为什么 Kubernetes 如此有用。

传统部署时代:

早期,各个组织机构在物理服务器上运行应用程序。无法为物理服务器中的应用程序定义资源边界,这会导致资源分配问题。 例如,如果在物理服务器上运行多个应用程序,则可能会出现一个应用程序占用大部分资源的情况, 结果可能导致其他应用程序的性能下降。 一种解决方案是在不同的物理服务器上运行每个应用程序,但是由于资源利用不足而无法扩展, 并且维护许多物理服务器的成本很高。

虚拟化部署时代:

作为解决方案,引入了虚拟化。虚拟化技术允许你在单个物理服务器的 CPU 上运行多个虚拟机(VM)。 虚拟化允许应用程序在 VM 之间隔离,并提供一定程度的安全,因为一个应用程序的信息 不能被另一应用程序随意访问。

虚拟化技术能够更好地利用物理服务器上的资源,并且因为可轻松地添加或更新应用程序 而可以实现更好的可伸缩性,降低硬件成本等等。

每个 VM 是一台完整的计算机,在虚拟化硬件之上运行所有组件,包括其自己的操作系统。

容器部署时代:

容器类似于 VM,但是它们具有被放宽的隔离属性,可以在应用程序之间共享操作系统(OS)。 因此,容器被认为是轻量级的。容器与 VM 类似,具有自己的文件系统、CPU、内存、进程空间等。 由于它们与基础架构分离,因此可以跨云和 OS 发行版本进行移植。

容器因具有许多优势而变得流行起来。下面列出的是容器的一些好处:

- 敏捷应用程序的创建和部署:与使用 VM 镜像相比,提高了容器镜像创建的简便性和效率。

- 持续开发、集成和部署:通过快速简单的回滚(由于镜像不可变性),支持可靠且频繁的 容器镜像构建和部署。

- 关注开发与运维的分离:在构建/发布时而不是在部署时创建应用程序容器镜像, 从而将应用程序与基础架构分离。

- 可观察性:不仅可以显示操作系统级别的信息和指标,还可以显示应用程序的运行状况和其他指标信号。

- 跨开发、测试和生产的环境一致性:在便携式计算机上与在云中相同地运行。

- 跨云和操作系统发行版本的可移植性:可在 Ubuntu、RHEL、CoreOS、本地、 Google Kubernetes Engine 和其他任何地方运行。

- 以应用程序为中心的管理:提高抽象级别,从在虚拟硬件上运行 OS 到使用逻辑资源在 OS 上运行应用程序。

- 松散耦合、分布式、弹性、解放的微服务:应用程序被分解成较小的独立部分, 并且可以动态部署和管理 - 而不是在一台大型单机上整体运行。

- 资源隔离:可预测的应用程序性能。

- 资源利用:高效率和高密度。

为什么需要 Kubernetes,它能做什么?

容器是打包和运行应用程序的好方式。在生产环境中,你需要管理运行应用程序的容器,并确保不会停机。 例如,如果一个容器发生故障,则需要启动另一个容器。如果系统处理此行为,会不会更容易?

这就是 Kubernetes 来解决这些问题的方法! Kubernetes 为你提供了一个可弹性运行分布式系统的框架。 Kubernetes 会满足你的扩展要求、故障转移、部署模式等。 例如,Kubernetes 可以轻松管理系统的 Canary 部署。

Kubernetes 为你提供:

-

服务发现和负载均衡

Kubernetes 可以使用 DNS 名称或自己的 IP 地址公开容器,如果进入容器的流量很大, Kubernetes 可以负载均衡并分配网络流量,从而使部署稳定。

-

存储编排

Kubernetes 允许你自动挂载你选择的存储系统,例如本地存储、公共云提供商等。

-

自动部署和回滚

你可以使用 Kubernetes 描述已部署容器的所需状态,它可以以受控的速率将实际状态 更改为期望状态。例如,你可以自动化 Kubernetes 来为你的部署创建新容器, 删除现有容器并将它们的所有资源用于新容器。

-

自动完成装箱计算

Kubernetes 允许你指定每个容器所需 CPU 和内存(RAM)。 当容器指定了资源请求时,Kubernetes 可以做出更好的决策来管理容器的资源。

-

自我修复

Kubernetes 重新启动失败的容器、替换容器、杀死不响应用户定义的 运行状况检查的容器,并且在准备好服务之前不将其通告给客户端。

-

密钥与配置管理

Kubernetes 允许你存储和管理敏感信息,例如密码、OAuth 令牌和 ssh 密钥。 你可以在不重建容器镜像的情况下部署和更新密钥和应用程序配置,也无需在堆栈配置中暴露密钥。

Kubernetes 不是什么

Kubernetes 不是传统的、包罗万象的 PaaS(平台即服务)系统。 由于 Kubernetes 在容器级别而不是在硬件级别运行,它提供了 PaaS 产品共有的一些普遍适用的功能, 例如部署、扩展、负载均衡、日志记录和监视。 但是,Kubernetes 不是单体系统,默认解决方案都是可选和可插拔的。 Kubernetes 提供了构建开发人员平台的基础,但是在重要的地方保留了用户的选择和灵活性。

Kubernetes:

- 不限制支持的应用程序类型。 Kubernetes 旨在支持极其多种多样的工作负载,包括无状态、有状态和数据处理工作负载。 如果应用程序可以在容器中运行,那么它应该可以在 Kubernetes 上很好地运行。

- 不部署源代码,也不构建你的应用程序。 持续集成(CI)、交付和部署(CI/CD)工作流取决于组织的文化和偏好以及技术要求。

- 不提供应用程序级别的服务作为内置服务,例如中间件(例如,消息中间件)、 数据处理框架(例如,Spark)、数据库(例如,mysql)、缓存、集群存储系统 (例如,Ceph)。这样的组件可以在 Kubernetes 上运行,并且/或者可以由运行在 Kubernetes 上的应用程序通过可移植机制(例如, 开放服务代理)来访问。

- 不要求日志记录、监视或警报解决方案。 它提供了一些集成作为概念证明,并提供了收集和导出指标的机制。

- 不提供或不要求配置语言/系统(例如 jsonnet),它提供了声明性 API, 该声明性 API 可以由任意形式的声明性规范所构成。

- 不提供也不采用任何全面的机器配置、维护、管理或自我修复系统。

- 此外,Kubernetes 不仅仅是一个编排系统,实际上它消除了编排的需要。 编排的技术定义是执行已定义的工作流程:首先执行 A,然后执行 B,再执行 C。 相比之下,Kubernetes 包含一组独立的、可组合的控制过程, 这些过程连续地将当前状态驱动到所提供的所需状态。 如何从 A 到 C 的方式无关紧要,也不需要集中控制,这使得系统更易于使用 且功能更强大、系统更健壮、更为弹性和可扩展。

接下来

- 查阅 Kubernetes 组件

- 开始 Kubernetes 入门?

1.2 - Kubernetes 组件

当你部署完 Kubernetes, 即拥有了一个完整的集群。

一个 Kubernetes 集群由一组被称作节点的机器组成。这些节点上运行 Kubernetes 所管理的容器化应用。集群具有至少一个工作节点。

工作节点托管作为应用负载的组件的 Pod 。控制平面管理集群中的工作节点和 Pod 。 为集群提供故障转移和高可用性,这些控制平面一般跨多主机运行,集群跨多个节点运行。

本文档概述了交付正常运行的 Kubernetes 集群所需的各种组件。

Kubernetes 集群的组件

控制平面组件(Control Plane Components)

控制平面的组件对集群做出全局决策(比如调度),以及检测和响应集群事件(例如,当不满足部署的

replicas 字段时,启动新的 pod)。

控制平面组件可以在集群中的任何节点上运行。 然而,为了简单起见,设置脚本通常会在同一个计算机上启动所有控制平面组件, 并且不会在此计算机上运行用户容器。 请参阅使用 kubeadm 构建高可用性集群 中关于多 VM 控制平面设置的示例。

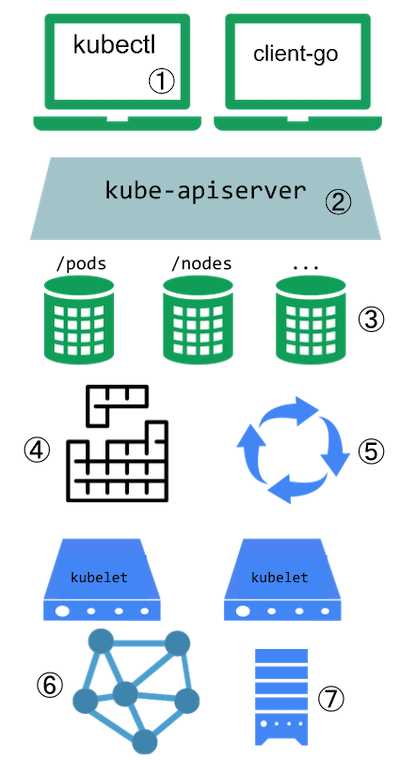

kube-apiserver

API 服务器是 Kubernetes 控制面的组件, 该组件公开了 Kubernetes API。 API 服务器是 Kubernetes 控制面的前端。

Kubernetes API 服务器的主要实现是 kube-apiserver。 kube-apiserver 设计上考虑了水平伸缩,也就是说,它可通过部署多个实例进行伸缩。 你可以运行 kube-apiserver 的多个实例,并在这些实例之间平衡流量。

etcd

etcd 是兼具一致性和高可用性的键值数据库,可以作为保存 Kubernetes 所有集群数据的后台数据库。

您的 Kubernetes 集群的 etcd 数据库通常需要有个备份计划。

要了解 etcd 更深层次的信息,请参考 etcd 文档。

kube-scheduler

控制平面组件,负责监视新创建的、未指定运行节点(node)的 Pods,选择节点让 Pod 在上面运行。

调度决策考虑的因素包括单个 Pod 和 Pod 集合的资源需求、硬件/软件/策略约束、亲和性和反亲和性规范、数据位置、工作负载间的干扰和最后时限。

kube-controller-manager

运行控制器进程的控制平面组件。

从逻辑上讲,每个控制器都是一个单独的进程, 但是为了降低复杂性,它们都被编译到同一个可执行文件,并在一个进程中运行。

这些控制器包括:

- 节点控制器(Node Controller): 负责在节点出现故障时进行通知和响应

- 任务控制器(Job controller): 监测代表一次性任务的 Job 对象,然后创建 Pods 来运行这些任务直至完成

- 端点控制器(Endpoints Controller): 填充端点(Endpoints)对象(即加入 Service 与 Pod)

- 服务帐户和令牌控制器(Service Account & Token Controllers): 为新的命名空间创建默认帐户和 API 访问令牌

cloud-controller-manager

云控制器管理器是指嵌入特定云的控制逻辑的 控制平面组件。 云控制器管理器使得你可以将你的集群连接到云提供商的 API 之上, 并将与该云平台交互的组件同与你的集群交互的组件分离开来。cloud-controller-manager 仅运行特定于云平台的控制回路。

如果你在自己的环境中运行 Kubernetes,或者在本地计算机中运行学习环境,

所部署的环境中不需要云控制器管理器。

与 kube-controller-manager 类似,cloud-controller-manager 将若干逻辑上独立的

控制回路组合到同一个可执行文件中,供你以同一进程的方式运行。

你可以对其执行水平扩容(运行不止一个副本)以提升性能或者增强容错能力。

下面的控制器都包含对云平台驱动的依赖:

- 节点控制器(Node Controller): 用于在节点终止响应后检查云提供商以确定节点是否已被删除

- 路由控制器(Route Controller): 用于在底层云基础架构中设置路由

- 服务控制器(Service Controller): 用于创建、更新和删除云提供商负载均衡器

Node 组件

节点组件在每个节点上运行,维护运行的 Pod 并提供 Kubernetes 运行环境。

kubelet

一个在集群中每个节点(node)上运行的代理。 它保证容器(containers)都 运行在 Pod 中。

kubelet 接收一组通过各类机制提供给它的 PodSpecs,确保这些 PodSpecs 中描述的容器处于运行状态且健康。 kubelet 不会管理不是由 Kubernetes 创建的容器。

kube-proxy

kube-proxy 是集群中每个节点上运行的网络代理, 实现 Kubernetes 服务(Service) 概念的一部分。

kube-proxy 维护节点上的网络规则。这些网络规则允许从集群内部或外部的网络会话与 Pod 进行网络通信。

如果操作系统提供了数据包过滤层并可用的话,kube-proxy 会通过它来实现网络规则。否则, kube-proxy 仅转发流量本身。

容器运行时(Container Runtime)

容器运行环境是负责运行容器的软件。

Kubernetes 支持多个容器运行环境: Docker、 containerd、CRI-O 以及任何实现 Kubernetes CRI (容器运行环境接口)。

插件(Addons)

插件使用 Kubernetes 资源(DaemonSet、

Deployment等)实现集群功能。

因为这些插件提供集群级别的功能,插件中命名空间域的资源属于 kube-system 命名空间。

下面描述众多插件中的几种。有关可用插件的完整列表,请参见 插件(Addons)。

DNS

尽管其他插件都并非严格意义上的必需组件,但几乎所有 Kubernetes 集群都应该 有集群 DNS, 因为很多示例都需要 DNS 服务。

集群 DNS 是一个 DNS 服务器,和环境中的其他 DNS 服务器一起工作,它为 Kubernetes 服务提供 DNS 记录。

Kubernetes 启动的容器自动将此 DNS 服务器包含在其 DNS 搜索列表中。

Web 界面(仪表盘)

Dashboard 是 Kubernetes 集群的通用的、基于 Web 的用户界面。 它使用户可以管理集群中运行的应用程序以及集群本身并进行故障排除。

容器资源监控

容器资源监控 将关于容器的一些常见的时间序列度量值保存到一个集中的数据库中,并提供用于浏览这些数据的界面。

集群层面日志

集群层面日志 机制负责将容器的日志数据 保存到一个集中的日志存储中,该存储能够提供搜索和浏览接口。

接下来

- 进一步了解节点

- 进一步了解控制器

- 进一步了解 kube-scheduler

- 阅读 etcd 官方文档

1.3 - Kubernetes API

Kubernetes 控制面 的核心是 API 服务器。 API 服务器负责提供 HTTP API,以供用户、集群中的不同部分和集群外部组件相互通信。

Kubernetes API 使你可以查询和操纵 Kubernetes API 中对象(例如:Pod、Namespace、ConfigMap 和 Event)的状态。

大部分操作都可以通过 kubectl 命令行接口或 类似 kubeadm 这类命令行工具来执行, 这些工具在背后也是调用 API。不过,你也可以使用 REST 调用来访问这些 API。

如果你正在编写程序来访问 Kubernetes API,可以考虑使用 客户端库之一。

OpenAPI 规范

完整的 API 细节是用 OpenAPI 来表述的。

Kubernetes API 服务器通过 /openapi/v2 末端提供 OpenAPI 规范。

你可以按照下表所给的请求头部,指定响应的格式:

| 头部 | 可选值 | 说明 |

|---|---|---|

Accept-Encoding |

gzip |

不指定此头部也是可以的 |

Accept |

application/com.github.proto-openapi.spec.v2@v1.0+protobuf |

主要用于集群内部 |

application/json |

默认值 | |

* |

提供application/json |

Kubernetes 为 API 实现了一种基于 Protobuf 的序列化格式,主要用于集群内部通信。 关于此格式的详细信息,可参考 Kubernetes Protobuf 序列化 设计提案。每种模式对应的接口描述语言(IDL)位于定义 API 对象的 Go 包中。

API 变更

任何成功的系统都要随着新的使用案例的出现和现有案例的变化来成长和变化。 为此,Kubernetes 的功能特性设计考虑了让 Kubernetes API 能够持续变更和成长的因素。 Kubernetes 项目的目标是 不要 引发现有客户端的兼容性问题,并在一定的时期内 维持这种兼容性,以便其他项目有机会作出适应性变更。

一般而言,新的 API 资源和新的资源字段可以被频繁地添加进来。 删除资源或者字段则要遵从 API 废弃策略。

关于什么是兼容性的变更、如何变更 API 等详细信息,可参考 API 变更。

API 组和版本

为了简化删除字段或者重构资源表示等工作,Kubernetes 支持多个 API 版本,

每一个版本都在不同 API 路径下,例如 /api/v1 或

/apis/rbac.authorization.k8s.io/v1alpha1。

版本化是在 API 级别而不是在资源或字段级别进行的,目的是为了确保 API 为系统资源和行为提供清晰、一致的视图,并能够控制对已废止的和/或实验性 API 的访问。

为了便于演化和扩展其 API,Kubernetes 实现了 可被启用或禁用的 API 组。

API 资源之间靠 API 组、资源类型、名字空间(对于名字空间作用域的资源而言)和

名字来相互区分。API 服务器可能通过多个 API 版本来向外提供相同的下层数据,

并透明地完成不同 API 版本之间的转换。所有这些不同的版本实际上都是同一资源

的(不同)表现形式。例如,假定同一资源有 v1 和 v1beta1 版本,

使用 v1beta1 创建的对象则可以使用 v1beta1 或者 v1 版本来读取、更改

或者删除。

关于 API 版本级别的详细定义,请参阅 API 版本参考。

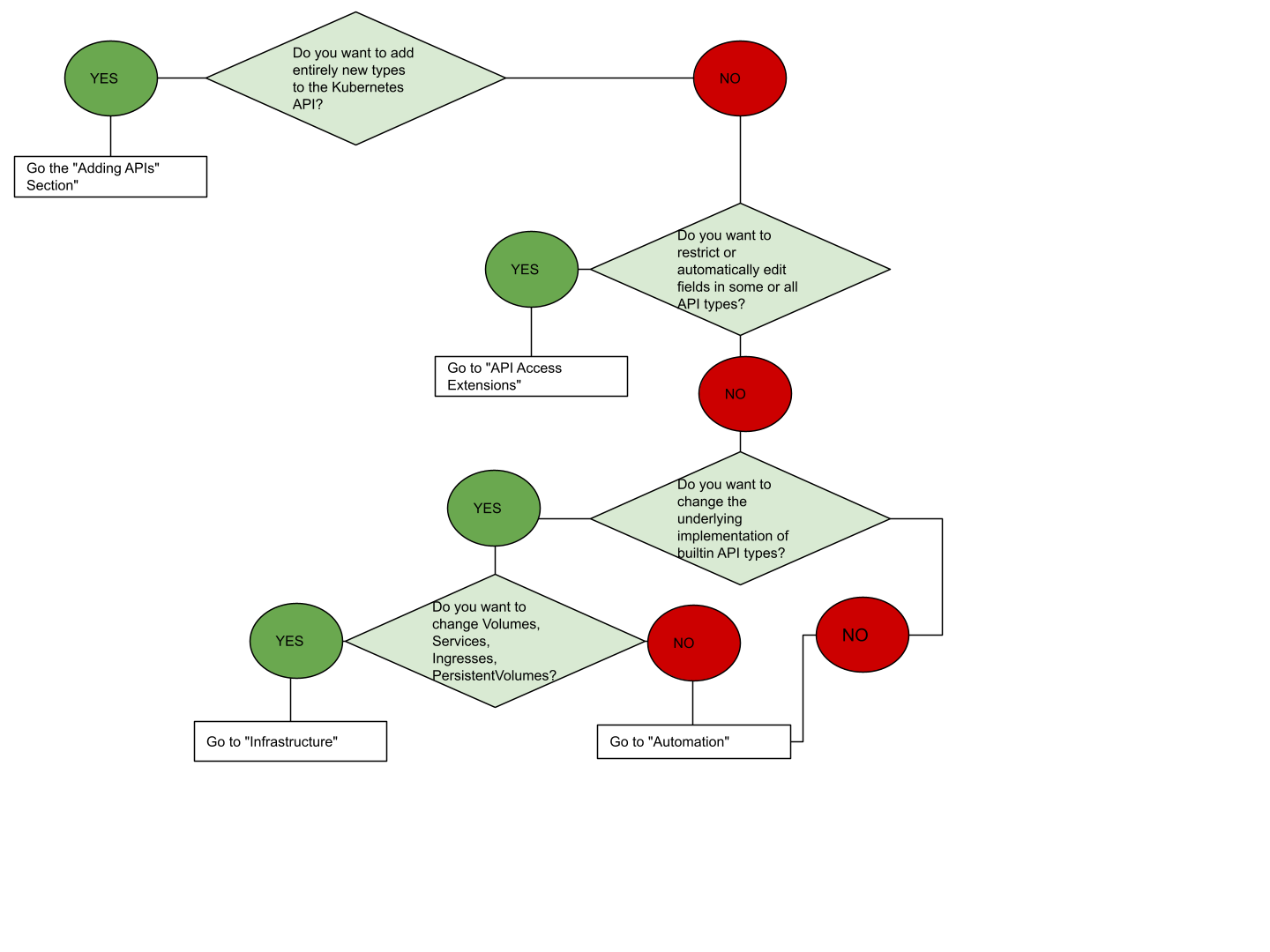

API 扩展

有两种途径来扩展 Kubernetes API:

接下来

- 了解如何通过添加你自己的 CustomResourceDefinition 来扩展 Kubernetes API。

- 控制 Kubernetes API 访问 页面描述了集群如何针对 API 访问管理身份认证和鉴权。

- 通过阅读 API 参考 了解 API 端点、资源类型以及示例。

1.4 - 使用 Kubernetes 对象

1.4.1 - 理解 Kubernetes 对象

本页说明了 Kubernetes 对象在 Kubernetes API 中是如何表示的,以及如何在 .yaml 格式的文件中表示。

理解 Kubernetes 对象

在 Kubernetes 系统中,Kubernetes 对象 是持久化的实体。 Kubernetes 使用这些实体去表示整个集群的状态。特别地,它们描述了如下信息:

- 哪些容器化应用在运行(以及在哪些节点上)

- 可以被应用使用的资源

- 关于应用运行时表现的策略,比如重启策略、升级策略,以及容错策略

Kubernetes 对象是 “目标性记录” —— 一旦创建对象,Kubernetes 系统将持续工作以确保对象存在。 通过创建对象,本质上是在告知 Kubernetes 系统,所需要的集群工作负载看起来是什么样子的, 这就是 Kubernetes 集群的 期望状态(Desired State)。

操作 Kubernetes 对象 —— 无论是创建、修改,或者删除 —— 需要使用

Kubernetes API。

比如,当使用 kubectl 命令行接口时,CLI 会执行必要的 Kubernetes API 调用,

也可以在程序中使用

客户端库直接调用 Kubernetes API。

对象规约(Spec)与状态(Status)

几乎每个 Kubernetes 对象包含两个嵌套的对象字段,它们负责管理对象的配置:

对象 spec(规约) 和 对象 status(状态) 。

对于具有 spec 的对象,你必须在创建对象时设置其内容,描述你希望对象所具有的特征:

期望状态(Desired State) 。

status 描述了对象的 当前状态(Current State),它是由 Kubernetes 系统和组件

设置并更新的。在任何时刻,Kubernetes

控制平面

都一直积极地管理着对象的实际状态,以使之与期望状态相匹配。

例如,Kubernetes 中的 Deployment 对象能够表示运行在集群中的应用。

当创建 Deployment 时,可能需要设置 Deployment 的 spec,以指定该应用需要有 3 个副本运行。

Kubernetes 系统读取 Deployment 规约,并启动我们所期望的应用的 3 个实例

—— 更新状态以与规约相匹配。

如果这些实例中有的失败了(一种状态变更),Kubernetes 系统通过执行修正操作

来响应规约和状态间的不一致 —— 在这里意味着它会启动一个新的实例来替换。

关于对象 spec、status 和 metadata 的更多信息,可参阅 Kubernetes API 约定。

描述 Kubernetes 对象

创建 Kubernetes 对象时,必须提供对象的规约,用来描述该对象的期望状态,

以及关于对象的一些基本信息(例如名称)。

当使用 Kubernetes API 创建对象时(或者直接创建,或者基于kubectl),

API 请求必须在请求体中包含 JSON 格式的信息。

大多数情况下,需要在 .yaml 文件中为 kubectl 提供这些信息。

kubectl 在发起 API 请求时,将这些信息转换成 JSON 格式。

这里有一个 .yaml 示例文件,展示了 Kubernetes Deployment 的必需字段和对象规约:

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

replicas: 2 # tells deployment to run 2 pods matching the template

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

使用类似于上面的 .yaml 文件来创建 Deployment的一种方式是使用 kubectl 命令行接口(CLI)中的

kubectl apply 命令,

将 .yaml 文件作为参数。下面是一个示例:

kubectl apply -f https://k8s.io/examples/application/deployment.yaml --record

输出类似如下这样:

deployment.apps/nginx-deployment created

必需字段

在想要创建的 Kubernetes 对象对应的 .yaml 文件中,需要配置如下的字段:

apiVersion- 创建该对象所使用的 Kubernetes API 的版本kind- 想要创建的对象的类别metadata- 帮助唯一性标识对象的一些数据,包括一个name字符串、UID 和可选的namespacespec- 你所期望的该对象的状态

对象 spec 的精确格式对每个 Kubernetes 对象来说是不同的,包含了特定于该对象的嵌套字段。

Kubernetes API 参考

能够帮助我们找到任何我们想创建的对象的规约格式。

例如,Pod 参考文档详细说明了 API 中 Pod 的 spec 字段,

Deployment 的参考文档则详细说明了 Deployment 的 spec 字段。

在这些 API 参考页面中,你将看到提到的 PodSpec 和 DeploymentSpec。

这些名字是 Kubernetes 用来实现其 API 的 Golang 代码的实现细节。

接下来

- 了解最重要的 Kubernetes 基本对象,例如 Pod。

- 了解 Kubernetes 中的控制器。

- 使用 Kubernetes API 一节解释了一些 API 概念。

1.4.2 - Kubernetes 对象管理

kubectl 命令行工具支持多种不同的方式来创建和管理 Kubernetes 对象。

本文档概述了不同的方法。

阅读 Kubectl book 来了解 kubectl

管理对象的详细信息。

管理技巧

应该只使用一种技术来管理 Kubernetes 对象。混合和匹配技术作用在同一对象上将导致未定义行为。

| 管理技术 | 作用于 | 建议的环境 | 支持的写者 | 学习难度 |

|---|---|---|---|---|

| 指令式命令 | 活跃对象 | 开发项目 | 1+ | 最低 |

| 指令式对象配置 | 单个文件 | 生产项目 | 1 | 中等 |

| 声明式对象配置 | 文件目录 | 生产项目 | 1+ | 最高 |

指令式命令

使用指令式命令时,用户可以在集群中的活动对象上进行操作。用户将操作传给

kubectl 命令作为参数或标志。

这是开始或者在集群中运行一次性任务的推荐方法。因为这个技术直接在活跃对象 上操作,所以它不提供以前配置的历史记录。

例子

通过创建 Deployment 对象来运行 nginx 容器的实例:

kubectl create deployment nginx --image nginx

权衡

与对象配置相比的优点:

- 命令简单,易学且易于记忆。

- 命令仅需一步即可对集群进行更改。

与对象配置相比的缺点:

- 命令不与变更审查流程集成。

- 命令不提供与更改关联的审核跟踪。

- 除了实时内容外,命令不提供记录源。

- 命令不提供用于创建新对象的模板。

指令式对象配置

在指令式对象配置中,kubectl 命令指定操作(创建,替换等),可选标志和 至少一个文件名。指定的文件必须包含 YAML 或 JSON 格式的对象的完整定义。

有关对象定义的详细信息,请查看 API 参考。

replace 指令式命令将现有规范替换为新提供的规范,并放弃对配置文件中

缺少的对象的所有更改。此方法不应与对象规约被独立于配置文件进行更新的

资源类型一起使用。比如类型为 LoadBalancer 的服务,它的 externalIPs

字段就是独立于集群配置进行更新。

例子

创建配置文件中定义的对象:

kubectl create -f nginx.yaml

删除两个配置文件中定义的对象:

kubectl delete -f nginx.yaml -f redis.yaml

通过覆盖活动配置来更新配置文件中定义的对象:

kubectl replace -f nginx.yaml

权衡

与指令式命令相比的优点:

- 对象配置可以存储在源控制系统中,比如 Git。

- 对象配置可以与流程集成,例如在推送和审计之前检查更新。

- 对象配置提供了用于创建新对象的模板。

与指令式命令相比的缺点:

- 对象配置需要对对象架构有基本的了解。

- 对象配置需要额外的步骤来编写 YAML 文件。

与声明式对象配置相比的优点:

- 指令式对象配置行为更加简单易懂。

- 从 Kubernetes 1.5 版本开始,指令对象配置更加成熟。

与声明式对象配置相比的缺点:

- 指令式对象配置更适合文件,而非目录。

- 对活动对象的更新必须反映在配置文件中,否则会在下一次替换时丢失。

声明式对象配置

使用声明式对象配置时,用户对本地存储的对象配置文件进行操作,但是用户

未定义要对该文件执行的操作。

kubectl 会自动检测每个文件的创建、更新和删除操作。

这使得配置可以在目录上工作,根据目录中配置文件对不同的对象执行不同的操作。

声明式对象配置保留其他编写者所做的修改,即使这些更改并未合并到对象配置文件中。

可以通过使用 patch API 操作仅写入观察到的差异,而不是使用 replace API

操作来替换整个对象配置来实现。

例子

处理 configs 目录中的所有对象配置文件,创建并更新活跃对象。

可以首先使用 diff 子命令查看将要进行的更改,然后在进行应用:

kubectl diff -f configs/

kubectl apply -f configs/

递归处理目录:

kubectl diff -R -f configs/

kubectl apply -R -f configs/

权衡

与指令式对象配置相比的优点:

- 对活动对象所做的更改即使未合并到配置文件中,也会被保留下来。

- 声明性对象配置更好地支持对目录进行操作并自动检测每个文件的操作类型(创建,修补,删除)。

与指令式对象配置相比的缺点:

- 声明式对象配置难于调试并且出现异常时结果难以理解。

- 使用 diff 产生的部分更新会创建复杂的合并和补丁操作。

接下来

1.4.3 - 对象名称和 IDs

集群中的每一个对象都有一个名称 来标识在同类资源中的唯一性。

每个 Kubernetes 对象也有一个UID 来标识在整个集群中的唯一性。

比如,在同一个名字空间

中有一个名为 myapp-1234 的 Pod, 但是可以命名一个 Pod 和一个 Deployment 同为 myapp-1234.

对于用户提供的非唯一性的属性,Kubernetes 提供了 标签(Labels)和 注解(Annotation)机制。

名称

客户端提供的字符串,引用资源 url 中的对象,如/api/v1/pods/some name。

某一时刻,只能有一个给定类型的对象具有给定的名称。但是,如果删除该对象,则可以创建同名的新对象。

当对象所代表的是一个物理实体(例如代表一台物理主机的 Node)时, 如果在 Node 对象未被删除并重建的条件下,重新创建了同名的物理主机, 则 Kubernetes 会将新的主机看作是老的主机,这可能会带来某种不一致性。

以下是比较常见的四种资源命名约束。

DNS 子域名

很多资源类型需要可以用作 DNS 子域名的名称。 DNS 子域名的定义可参见 RFC 1123。 这一要求意味着名称必须满足如下规则:

- 不能超过253个字符

- 只能包含小写字母、数字,以及'-' 和 '.'

- 须以字母数字开头

- 须以字母数字结尾

RFC 1123 标签名

某些资源类型需要其名称遵循 RFC 1123 所定义的 DNS 标签标准。也就是命名必须满足如下规则:

- 最多 63 个字符

- 只能包含小写字母、数字,以及 '-'

- 须以字母数字开头

- 须以字母数字结尾

RFC 1035 标签名

某些资源类型需要其名称遵循 RFC 1035 所定义的 DNS 标签标准。也就是命名必须满足如下规则:

- 最多 63 个字符

- 只能包含小写字母、数字,以及 '-'

- 须以字母开头

- 须以字母数字结尾

路径分段名称

某些资源类型要求名称能被安全地用作路径中的片段。

换句话说,其名称不能是 .、..,也不可以包含 / 或 % 这些字符。

下面是一个名为nginx-demo的 Pod 的配置清单:

apiVersion: v1

kind: Pod

metadata:

name: nginx-demo

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

UIDs

Kubernetes 系统生成的字符串,唯一标识对象。

在 Kubernetes 集群的整个生命周期中创建的每个对象都有一个不同的 uid,它旨在区分类似实体的历史事件。

Kubernetes UIDs 是全局唯一标识符(也叫 UUIDs)。 UUIDs 是标准化的,见 ISO/IEC 9834-8 和 ITU-T X.667.

接下来

- 进一步了解 Kubernetes 标签

- 参阅 Kubernetes 标识符和名称的设计文档

1.4.4 - 名字空间

Kubernetes 支持多个虚拟集群,它们底层依赖于同一个物理集群。 这些虚拟集群被称为名字空间。 在一些文档里名字空间也称为命名空间。

何时使用多个名字空间

名字空间适用于存在很多跨多个团队或项目的用户的场景。对于只有几到几十个用户的集群,根本不需要创建或考虑名字空间。当需要名称空间提供的功能时,请开始使用它们。

名字空间为名称提供了一个范围。资源的名称需要在名字空间内是唯一的,但不能跨名字空间。 名字空间不能相互嵌套,每个 Kubernetes 资源只能在一个名字空间中。

名字空间是在多个用户之间划分集群资源的一种方法(通过资源配额)。

不必使用多个名字空间来分隔仅仅轻微不同的资源,例如同一软件的不同版本: 应该使用标签 来区分同一名字空间中的不同资源。

使用名字空间

名字空间的创建和删除在名字空间的管理指南文档描述。

kube- 创建名字空间,因为它是为 Kubernetes 系统名字空间保留的。

查看名字空间

你可以使用以下命令列出集群中现存的名字空间:

kubectl get namespace

NAME STATUS AGE

default Active 1d

kube-node-lease Active 1d

kube-system Active 1d

kube-public Active 1d

Kubernetes 会创建四个初始名字空间:

default没有指明使用其它名字空间的对象所使用的默认名字空间kube-systemKubernetes 系统创建对象所使用的名字空间kube-public这个名字空间是自动创建的,所有用户(包括未经过身份验证的用户)都可以读取它。 这个名字空间主要用于集群使用,以防某些资源在整个集群中应该是可见和可读的。 这个名字空间的公共方面只是一种约定,而不是要求。kube-node-lease此名字空间用于与各个节点相关的 租约(Lease)对象。 节点租期允许 kubelet 发送心跳,由此控制面能够检测到节点故障。

为请求设置名字空间

要为当前请求设置名字空间,请使用 --namespace 参数。

例如:

kubectl run nginx --image=nginx --namespace=<名字空间名称>

kubectl get pods --namespace=<名字空间名称>

设置名字空间偏好

你可以永久保存名字空间,以用于对应上下文中所有后续 kubectl 命令。

kubectl config set-context --current --namespace=<名字空间名称>

# 验证之

kubectl config view | grep namespace:

名字空间和 DNS

当你创建一个服务 时, Kubernetes 会创建一个相应的 DNS 条目。

该条目的形式是 <服务名称>.<名字空间名称>.svc.cluster.local,这意味着如果容器只使用

<服务名称>,它将被解析到本地名字空间的服务。这对于跨多个名字空间(如开发、分级和生产)

使用相同的配置非常有用。如果你希望跨名字空间访问,则需要使用完全限定域名(FQDN)。

并非所有对象都在名字空间中

大多数 kubernetes 资源(例如 Pod、Service、副本控制器等)都位于某些名字空间中。 但是名字空间资源本身并不在名字空间中。而且底层资源,例如 节点 和持久化卷不属于任何名字空间。

查看哪些 Kubernetes 资源在名字空间中,哪些不在名字空间中:

# 位于名字空间中的资源

kubectl api-resources --namespaced=true

# 不在名字空间中的资源

kubectl api-resources --namespaced=false

自动打标签

Kubernetes 1.21 [beta]

Kubernetes 控制面会为所有名字空间设置一个不可变更的

标签

kubernetes.io/metadata.name,只要 NamespaceDefaultLabelName 这一

特性门控

被启用。标签的值是名字空间的名称。

接下来

1.4.5 - 标签和选择算符

标签(Labels) 是附加到 Kubernetes 对象(比如 Pods)上的键值对。 标签旨在用于指定对用户有意义且相关的对象的标识属性,但不直接对核心系统有语义含义。 标签可以用于组织和选择对象的子集。标签可以在创建时附加到对象,随后可以随时添加和修改。 每个对象都可以定义一组键/值标签。每个键对于给定对象必须是唯一的。

"metadata": {

"labels": {

"key1" : "value1",

"key2" : "value2"

}

}

标签能够支持高效的查询和监听操作,对于用户界面和命令行是很理想的。 应使用注解 记录非识别信息。

动机

标签使用户能够以松散耦合的方式将他们自己的组织结构映射到系统对象,而无需客户端存储这些映射。

服务部署和批处理流水线通常是多维实体(例如,多个分区或部署、多个发行序列、多个层,每层多个微服务)。 管理通常需要交叉操作,这打破了严格的层次表示的封装,特别是由基础设施而不是用户确定的严格的层次结构。

示例标签:

"release" : "stable","release" : "canary""environment" : "dev","environment" : "qa","environment" : "production""tier" : "frontend","tier" : "backend","tier" : "cache""partition" : "customerA","partition" : "customerB""track" : "daily","track" : "weekly"

有一些常用标签的例子; 你可以任意制定自己的约定。 请记住,标签的 Key 对于给定对象必须是唯一的。

语法和字符集

标签 是键值对。有效的标签键有两个段:可选的前缀和名称,用斜杠(/)分隔。

名称段是必需的,必须小于等于 63 个字符,以字母数字字符([a-z0-9A-Z])开头和结尾,

带有破折号(-),下划线(_),点( .)和之间的字母数字。

前缀是可选的。如果指定,前缀必须是 DNS 子域:由点(.)分隔的一系列 DNS 标签,总共不超过 253 个字符,

后跟斜杠(/)。

如果省略前缀,则假定标签键对用户是私有的。

向最终用户对象添加标签的自动系统组件(例如 kube-scheduler、kube-controller-manager、

kube-apiserver、kubectl 或其他第三方自动化工具)必须指定前缀。

kubernetes.io/ 和 k8s.io/ 前缀是为 Kubernetes 核心组件保留的。

有效标签值:

- 必须为 63 个字符或更少(可以为空)

- 除非标签值为空,必须以字母数字字符(

[a-z0-9A-Z])开头和结尾 - 包含破折号(

-)、下划线(_)、点(.)和字母或数字。

标签选择算符

与名称和 UID 不同, 标签不支持唯一性。通常,我们希望许多对象携带相同的标签。

通过 标签选择算符,客户端/用户可以识别一组对象。标签选择算符是 Kubernetes 中的核心分组原语。

API 目前支持两种类型的选择算符:基于等值的 和 基于集合的。

标签选择算符可以由逗号分隔的多个 需求 组成。

在多个需求的情况下,必须满足所有要求,因此逗号分隔符充当逻辑 与(&&)运算符。

空标签选择算符或者未指定的选择算符的语义取决于上下文, 支持使用选择算符的 API 类别应该将算符的合法性和含义用文档记录下来。

||)操作符。

你要确保你的过滤语句按合适的方式组织。

基于等值的 需求

基于等值 或 基于不等值 的需求允许按标签键和值进行过滤。

匹配对象必须满足所有指定的标签约束,尽管它们也可能具有其他标签。

可接受的运算符有=、== 和 != 三种。

前两个表示 相等(并且只是同义词),而后者表示 不相等。例如:

environment = production

tier != frontend

前者选择所有资源,其键名等于 environment,值等于 production。

后者选择所有资源,其键名等于 tier,值不同于 frontend,所有资源都没有带有 tier 键的标签。

可以使用逗号运算符来过滤 production 环境中的非 frontend 层资源:environment=production,tier!=frontend。

基于等值的标签要求的一种使用场景是 Pod 要指定节点选择标准。

例如,下面的示例 Pod 选择带有标签 "accelerator=nvidia-tesla-p100"。

apiVersion: v1

kind: Pod

metadata:

name: cuda-test

spec:

containers:

- name: cuda-test

image: "k8s.gcr.io/cuda-vector-add:v0.1"

resources:

limits:

nvidia.com/gpu: 1

nodeSelector:

accelerator: nvidia-tesla-p100

基于集合 的需求

基于集合 的标签需求允许你通过一组值来过滤键。

支持三种操作符:in、notin 和 exists (只可以用在键标识符上)。例如:

environment in (production, qa)

tier notin (frontend, backend)

partition

!partition

- 第一个示例选择了所有键等于

environment并且值等于production或者qa的资源。 - 第二个示例选择了所有键等于

tier并且值不等于frontend或者backend的资源,以及所有没有tier键标签的资源。 - 第三个示例选择了所有包含了有

partition标签的资源;没有校验它的值。 - 第四个示例选择了所有没有

partition标签的资源;没有校验它的值。 类似地,逗号分隔符充当 与 运算符。因此,使用partition键(无论为何值)和environment不同于qa来过滤资源可以使用partition, environment notin(qa)来实现。

基于集合 的标签选择算符是相等标签选择算符的一般形式,因为 environment=production

等同于 environment in(production);!= 和 notin 也是类似的。

基于集合 的要求可以与基于 相等 的要求混合使用。例如:partition in (customerA, customerB),environment!=qa。

API

LIST 和 WATCH 过滤

LIST 和 WATCH 操作可以使用查询参数指定标签选择算符过滤一组对象。 两种需求都是允许的。(这里显示的是它们出现在 URL 查询字符串中)

- 基于等值 的需求:

?labelSelector=environment%3Dproduction,tier%3Dfrontend - 基于集合 的需求:

?labelSelector=environment+in+%28production%2Cqa%29%2Ctier+in+%28frontend%29

两种标签选择算符都可以通过 REST 客户端用于 list 或者 watch 资源。

例如,使用 kubectl 定位 apiserver,可以使用 基于等值 的标签选择算符可以这么写:

kubectl get pods -l environment=production,tier=frontend

或者使用 基于集合的 需求:

kubectl get pods -l 'environment in (production),tier in (frontend)'

正如刚才提到的,基于集合 的需求更具有表达力。例如,它们可以实现值的 或 操作:

kubectl get pods -l 'environment in (production, qa)'

或者通过 exists 运算符限制不匹配:

kubectl get pods -l 'environment,environment notin (frontend)'

在 API 对象中设置引用

一些 Kubernetes 对象,例如 services

和 replicationcontrollers ,

也使用了标签选择算符去指定了其他资源的集合,例如

pods。

Service 和 ReplicationController

一个 Service 指向的一组 Pods 是由标签选择算符定义的。同样,一个 ReplicationController

应该管理的 pods 的数量也是由标签选择算符定义的。

两个对象的标签选择算符都是在 json 或者 yaml 文件中使用映射定义的,并且只支持

基于等值 需求的选择算符:

"selector": {

"component" : "redis",

}

或者

selector:

component: redis

这个选择算符(分别在 json 或者 yaml 格式中) 等价于 component=redis 或 component in (redis) 。

支持基于集合需求的资源

比较新的资源,例如 Job、

Deployment、

Replica Set 和

DaemonSet ,

也支持 基于集合的 需求。

selector:

matchLabels:

component: redis

matchExpressions:

- {key: tier, operator: In, values: [cache]}

- {key: environment, operator: NotIn, values: [dev]}

matchLabels 是由 {key,value} 对组成的映射。

matchLabels 映射中的单个 {key,value } 等同于 matchExpressions 的元素,

其 key 字段为 "key",operator 为 "In",而 values 数组仅包含 "value"。

matchExpressions 是 Pod 选择算符需求的列表。

有效的运算符包括 In、NotIn、Exists 和 DoesNotExist。

在 In 和 NotIn 的情况下,设置的值必须是非空的。

来自 matchLabels 和 matchExpressions 的所有要求都按逻辑与的关系组合到一起

-- 它们必须都满足才能匹配。

选择节点集

通过标签进行选择的一个用例是确定节点集,方便 Pod 调度。 有关更多信息,请参阅选择节点文档。

1.4.6 - 注解

你可以使用 Kubernetes 注解为对象附加任意的非标识的元数据。客户端程序(例如工具和库)能够获取这些元数据信息。

为对象附加元数据

你可以使用标签或注解将元数据附加到 Kubernetes 对象。 标签可以用来选择对象和查找满足某些条件的对象集合。 相反,注解不用于标识和选择对象。 注解中的元数据,可以很小,也可以很大,可以是结构化的,也可以是非结构化的,能够包含标签不允许的字符。

注解和标签一样,是键/值对:

"metadata": {

"annotations": {

"key1" : "value1",

"key2" : "value2"

}

}

Map 中的键和值必须是字符串。 换句话说,你不能使用数字、布尔值、列表或其他类型的键或值。

以下是一些例子,用来说明哪些信息可以使用注解来记录:

- 由声明性配置所管理的字段。 将这些字段附加为注解,能够将它们与客户端或服务端设置的默认值、 自动生成的字段以及通过自动调整大小或自动伸缩系统设置的字段区分开来。

- 构建、发布或镜像信息(如时间戳、发布 ID、Git 分支、PR 数量、镜像哈希、仓库地址)。

- 指向日志记录、监控、分析或审计仓库的指针。

-

可用于调试目的的客户端库或工具信息:例如,名称、版本和构建信息。

-

用户或者工具/系统的来源信息,例如来自其他生态系统组件的相关对象的 URL。

-

轻量级上线工具的元数据信息:例如,配置或检查点。

-

负责人员的电话或呼机号码,或指定在何处可以找到该信息的目录条目,如团队网站。

-

从用户到最终运行的指令,以修改行为或使用非标准功能。

你可以将这类信息存储在外部数据库或目录中而不使用注解, 但这样做就使得开发人员很难生成用于部署、管理、自检的客户端共享库和工具。

语法和字符集

注解(Annotations) 存储的形式是键/值对。有效的注解键分为两部分:

可选的前缀和名称,以斜杠(/)分隔。

名称段是必需项,并且必须在63个字符以内,以字母数字字符([a-z0-9A-Z])开头和结尾,

并允许使用破折号(-),下划线(_),点(.)和字母数字。

前缀是可选的。如果指定,则前缀必须是DNS子域:一系列由点(.)分隔的DNS标签,

总计不超过253个字符,后跟斜杠(/)。

如果省略前缀,则假定注解键对用户是私有的。 由系统组件添加的注解

(例如,kube-scheduler,kube-controller-manager,kube-apiserver,kubectl

或其他第三方组件),必须为终端用户添加注解前缀。

kubernetes.io/ 和 k8s.io/ 前缀是为Kubernetes核心组件保留的。

例如,下面是一个 Pod 的配置文件,其注解中包含 imageregistry: https://hub.docker.com/:

apiVersion: v1

kind: Pod

metadata:

name: annotations-demo

annotations:

imageregistry: "https://hub.docker.com/"

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

接下来

- 进一步了解标签和选择算符。

1.4.7 - Finalizers

Finalizer 是带有命名空间的键,告诉 Kubernetes 等到特定的条件被满足后, 再完全删除被标记为删除的资源。 Finalizer 提醒控制器清理被删除的对象拥有的资源。

当你告诉 Kubernetes 删除一个指定了 Finalizer 的对象时,

Kubernetes API 会将该对象标记为删除,使其进入只读状态。

此时控制平面或其他组件会采取 Finalizer 所定义的行动,

而目标对象仍然处于终止中(Terminating)的状态。

这些行动完成后,控制器会删除目标对象相关的 Finalizer。

当 metadata.finalizers 字段为空时,Kubernetes 认为删除已完成。

你可以使用 Finalizer 控制资源的垃圾收集。 例如,你可以定义一个 Finalizer,在删除目标资源前清理相关资源或基础设施。

你可以通过使用 Finalizers 提醒控制器 在删除目标资源前执行特定的清理任务, 来控制资源的垃圾收集。

Finalizers 通常不指定要执行的代码。 相反,它们通常是特定资源上的键的列表,类似于注解。 Kubernetes 自动指定了一些 Finalizers,但你也可以指定你自己的。

Finalizers 如何工作

当你使用清单文件创建资源时,你可以在 metadata.finalizers 字段指定 Finalizers。

当你试图删除该资源时,管理该资源的控制器会注意到 finalizers 字段中的值,

并进行以下操作:

- 修改对象,将你开始执行删除的时间添加到

metadata.deletionTimestamp字段。 - 将该对象标记为只读,直到其

metadata.finalizers字段为空。

然后,控制器试图满足资源的 Finalizers 的条件。

每当一个 Finalizer 的条件被满足时,控制器就会从资源的 finalizers 字段中删除该键。

当该字段为空时,垃圾收集继续进行。

你也可以使用 Finalizers 来阻止删除未被管理的资源。

一个常见的 Finalizer 的例子是 kubernetes.io/pv-protection,

它用来防止意外删除 PersistentVolume 对象。

当一个 PersistentVolume 对象被 Pod 使用时,

Kubernetes 会添加 pv-protection Finalizer。

如果你试图删除 PersistentVolume,它将进入 Terminating 状态,

但是控制器因为该 Finalizer 存在而无法删除该资源。

当 Pod 停止使用 PersistentVolume 时,

Kubernetes 清除 pv-protection Finalizer,控制器就会删除该卷。

属主引用、标签和 Finalizers

与标签类似, 属主引用 描述了 Kubernetes 中对象之间的关系,但它们作用不同。 当一个控制器 管理类似于 Pod 的对象时,它使用标签来跟踪相关对象组的变化。 例如,当 Job 创建一个或多个 Pod 时, Job 控制器会给这些 Pod 应用上标签,并跟踪集群中的具有相同标签的 Pod 的变化。

Job 控制器还为这些 Pod 添加了属主引用,指向创建 Pod 的 Job。 如果你在这些 Pod 运行的时候删除了 Job, Kubernetes 会使用属主引用(而不是标签)来确定集群中哪些 Pod 需要清理。

当 Kubernetes 识别到要删除的资源上的属主引用时,它也会处理 Finalizers。

在某些情况下,Finalizers 会阻止依赖对象的删除, 这可能导致目标属主对象,保持在只读状态的时间比预期的长,且没有被完全删除。 在这些情况下,你应该检查目标属主和附属对象上的 Finalizers 和属主引用,来排查原因。

在对象卡在删除状态的情况下,尽量避免手动移除 Finalizers,以允许继续删除操作。 Finalizers 通常因为特殊原因被添加到资源上,所以强行删除它们会导致集群出现问题。

接下来

- 阅读 Kubernetes 博客的使用 Finalizers 控制删除。

1.4.8 - 字段选择器

字段选择器(Field selectors)允许你根据一个或多个资源字段的值 筛选 Kubernetes 资源。 下面是一些使用字段选择器查询的例子:

metadata.name=my-servicemetadata.namespace!=defaultstatus.phase=Pending

下面这个 kubectl 命令将筛选出 status.phase

字段值为 Running 的所有 Pod:

kubectl get pods --field-selector status.phase=Running

字段选择器本质上是资源过滤器(Filters)。默认情况下,字段选择器/过滤器是未被应用的,

这意味着指定类型的所有资源都会被筛选出来。

这使得以下的两个 kubectl 查询是等价的:

kubectl get pods

kubectl get pods --field-selector ""

支持的字段

不同的 Kubernetes 资源类型支持不同的字段选择器。

所有资源类型都支持 metadata.name 和 metadata.namespace 字段。

使用不被支持的字段选择器会产生错误。例如:

kubectl get ingress --field-selector foo.bar=baz

Error from server (BadRequest): Unable to find "ingresses" that match label selector "", field selector "foo.bar=baz": "foo.bar" is not a known field selector: only "metadata.name", "metadata.namespace"

支持的操作符

你可在字段选择器中使用 =、==和 != (= 和 == 的意义是相同的)操作符。

例如,下面这个 kubectl 命令将筛选所有不属于 default 命名空间的 Kubernetes 服务:

kubectl get services --all-namespaces --field-selector metadata.namespace!=default

链式选择器

同标签和其他选择器一样,

字段选择器可以通过使用逗号分隔的列表组成一个选择链。

下面这个 kubectl 命令将筛选 status.phase 字段不等于 Running 同时

spec.restartPolicy 字段等于 Always 的所有 Pod:

kubectl get pods --field-selector=status.phase!=Running,spec.restartPolicy=Always

多种资源类型

你能够跨多种资源类型来使用字段选择器。

下面这个 kubectl 命令将筛选出所有不在 default 命名空间中的 StatefulSet 和 Service:

kubectl get statefulsets,services --all-namespaces --field-selector metadata.namespace!=default

1.4.9 - 属主与附属

在 Kubernetes 中,一些对象是其他对象的属主(Owner)。 例如,ReplicaSet 是一组 Pod 的属主。 具有属主的对象是属主的附属(Dependent) 。

属主关系不同于一些资源使用的标签和选择算符机制。

例如,有一个创建 EndpointSlice 对象的 Service,

该 Service 使用标签来让控制平面确定,哪些 EndpointSlice 对象属于该 Service。

除开标签,每个代表 Service 所管理的 EndpointSlice 都有一个属主引用。

属主引用避免 Kubernetes 的不同部分干扰到不受它们控制的对象。

对象规约中的属主引用

附属对象有一个 metadata.ownerReferences 字段,用于引用其属主对象。

一个有效的属主引用,包含与附属对象同在一个命名空间下的对象名称和一个 UID。

Kubernetes 自动为一些对象的附属资源设置属主引用的值,

这些对象包含 ReplicaSet、DaemonSet、Deployment、Job、CronJob、ReplicationController 等。

你也可以通过改变这个字段的值,来手动配置这些关系。

然而,你通常不需要这么做,你可以让 Kubernetes 自动管理附属关系。

附属对象还有一个 ownerReferences.blockOwnerDeletion 字段,该字段使用布尔值,

用于控制特定的附属对象是否可以阻止垃圾收集删除其属主对象。

如果控制器(例如 Deployment 控制器)

设置了 metadata.ownerReferences 字段的值,Kubernetes 会自动设置

blockOwnerDeletion 的值为 true。

你也可以手动设置 blockOwnerDeletion 字段的值,以控制哪些附属对象会阻止垃圾收集。

根据设计,kubernetes 不允许跨名字空间指定属主。 名字空间范围的附属可以指定集群范围的或者名字空间范围的属主。 名字空间范围的属主必须和该附属处于相同的名字空间。 如果名字空间范围的属主和附属不在相同的名字空间,那么该属主引用就会被认为是缺失的, 并且当附属的所有属主引用都被确认不再存在之后,该附属就会被删除。

集群范围的附属只能指定集群范围的属主。 在 v1.20+ 版本,如果一个集群范围的附属指定了一个名字空间范围类型的属主, 那么该附属就会被认为是拥有一个不可解析的属主引用,并且它不能够被垃圾回收。

在 v1.20+ 版本,如果垃圾收集器检测到无效的跨名字空间的属主引用,

或者一个集群范围的附属指定了一个名字空间范围类型的属主,

那么它就会报告一个警告事件。该事件的原因是 OwnerRefInvalidNamespace,

involvedObject 属性中包含无效的附属。

你可以运行 kubectl get events -A --field-selector=reason=OwnerRefInvalidNamespace

来获取该类型的事件。

属主关系与 Finalizer

当你告诉 Kubernetes 删除一个资源,API 服务器允许管理控制器处理该资源的任何

Finalizer 规则。

Finalizer

防止意外删除你的集群所依赖的、用于正常运作的资源。

例如,如果你试图删除一个仍被 Pod 使用的 PersistentVolume,该资源不会被立即删除,

因为 PersistentVolume 有 kubernetes.io/pv-protection Finalizer。

相反,它将进入 Terminating 状态,直到 Kubernetes 清除这个 Finalizer,

而这种情况只会发生在 PersistentVolume 不再被挂载到 Pod 上时。

当你使用前台或孤立级联删除时,

Kubernetes 也会向属主资源添加 Finalizer。

在前台删除中,会添加 foreground Finalizer,这样控制器必须在删除了拥有

ownerReferences.blockOwnerDeletion=true 的附属资源后,才能删除属主对象。

如果你指定了孤立删除策略,Kubernetes 会添加 orphan Finalizer,

这样控制器在删除属主对象后,会忽略附属资源。

接下来

- 了解更多关于 Kubernetes Finalizer。

- 了解关于垃圾收集。

- 阅读对象元数据的 API 参考文档。

1.4.10 - 推荐使用的标签

除了 kubectl 和 dashboard 之外,您可以使用其他工具来可视化和管理 Kubernetes 对象。一组通用的标签可以让多个工具之间相互操作,用所有工具都能理解的通用方式描述对象。

除了支持工具外,推荐的标签还以一种可以查询的方式描述了应用程序。

元数据围绕 应用(application) 的概念进行组织。Kubernetes 不是 平台即服务(PaaS),没有或强制执行正式的应用程序概念。 相反,应用程序是非正式的,并使用元数据进行描述。应用程序包含的定义是松散的。

这些是推荐的标签。它们使管理应用程序变得更容易但不是任何核心工具所必需的。

共享标签和注解都使用同一个前缀:app.kubernetes.io。没有前缀的标签是用户私有的。共享前缀可以确保共享标签不会干扰用户自定义的标签。

标签

为了充分利用这些标签,应该在每个资源对象上都使用它们。

| 键 | 描述 | 示例 | 类型 |

|---|---|---|---|

app.kubernetes.io/name |

应用程序的名称 | mysql |

字符串 |

app.kubernetes.io/instance |

用于唯一确定应用实例的名称 | mysql-abcxzy |

字符串 |

app.kubernetes.io/version |

应用程序的当前版本(例如,语义版本,修订版哈希等) | 5.7.21 |

字符串 |

app.kubernetes.io/component |

架构中的组件 | database |

字符串 |

app.kubernetes.io/part-of |

此级别的更高级别应用程序的名称 | wordpress |

字符串 |

app.kubernetes.io/managed-by |

用于管理应用程序的工具 | helm |

字符串 |

app.kubernetes.io/created-by |

创建该资源的控制器或者用户 | controller-manager |

字符串 |

为说明这些标签的实际使用情况,请看下面的 StatefulSet 对象:

# 这是一段节选

apiVersion: apps/v1

kind: StatefulSet

metadata:

labels:

app.kubernetes.io/name: mysql

app.kubernetes.io/instance: mysql-abcxzy

app.kubernetes.io/version: "5.7.21"

app.kubernetes.io/component: database

app.kubernetes.io/part-of: wordpress

app.kubernetes.io/managed-by: helm

app.kubernetes.io/created-by: controller-manager

应用和应用实例

应用可以在 Kubernetes 集群中安装一次或多次。在某些情况下,可以安装在同一命名空间中。例如,可以不止一次地为不同的站点安装不同的 WordPress。

应用的名称和实例的名称是分别记录的。例如,WordPress 应用的

app.kubernetes.io/name 为 wordpress,而其实例名称

app.kubernetes.io/instance 为 wordpress-abcxzy。

这使得应用和应用的实例均可被识别,应用的每个实例都必须具有唯一的名称。

示例

为了说明使用这些标签的不同方式,以下示例具有不同的复杂性。

一个简单的无状态服务

考虑使用 Deployment 和 Service 对象部署的简单无状态服务的情况。以下两个代码段表示如何以最简单的形式使用标签。

下面的 Deployment 用于监督运行应用本身的 pods。

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app.kubernetes.io/name: myservice

app.kubernetes.io/instance: myservice-abcxzy

...

下面的 Service 用于暴露应用。

apiVersion: v1

kind: Service

metadata:

labels:

app.kubernetes.io/name: myservice

app.kubernetes.io/instance: myservice-abcxzy

...

带有一个数据库的 Web 应用程序

考虑一个稍微复杂的应用:一个使用 Helm 安装的 Web 应用(WordPress),其中 使用了数据库(MySQL)。以下代码片段说明用于部署此应用程序的对象的开始。

以下 Deployment 的开头用于 WordPress:

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app.kubernetes.io/name: wordpress

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/version: "4.9.4"

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: server

app.kubernetes.io/part-of: wordpress

...

这个 Service 用于暴露 WordPress:

apiVersion: v1

kind: Service

metadata:

labels:

app.kubernetes.io/name: wordpress

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/version: "4.9.4"

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: server

app.kubernetes.io/part-of: wordpress

...

MySQL 作为一个 StatefulSet 暴露,包含它和它所属的较大应用程序的元数据:

apiVersion: apps/v1

kind: StatefulSet

metadata:

labels:

app.kubernetes.io/name: mysql

app.kubernetes.io/instance: mysql-abcxzy

app.kubernetes.io/version: "5.7.21"

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: database

app.kubernetes.io/part-of: wordpress

...

Service 用于将 MySQL 作为 WordPress 的一部分暴露:

apiVersion: v1

kind: Service

metadata:

labels:

app.kubernetes.io/name: mysql

app.kubernetes.io/instance: mysql-abcxzy

app.kubernetes.io/version: "5.7.21"

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: database

app.kubernetes.io/part-of: wordpress

...

使用 MySQL StatefulSet 和 Service,您会注意到有关 MySQL 和 Wordpress 的信息,包括更广泛的应用程序。

2 - Kubernetes 架构

2.1 - 节点

Kubernetes 通过将容器放入在节点(Node)上运行的 Pod 中来执行你的工作负载。 节点可以是一个虚拟机或者物理机器,取决于所在的集群配置。 每个节点包含运行 Pods 所需的服务; 这些节点由 控制面 负责管理。

通常集群中会有若干个节点;而在一个学习用或者资源受限的环境中,你的集群中也可能 只有一个节点。

节点上的组件包括 kubelet、 容器运行时以及 kube-proxy。

管理

向 API 服务器添加节点的方式主要有两种:

- 节点上的

kubelet向控制面执行自注册; - 你,或者别的什么人,手动添加一个 Node 对象。

在你创建了 Node 对象或者节点上的 kubelet 执行了自注册操作之后,

控制面会检查新的 Node 对象是否合法。例如,如果你使用下面的 JSON

对象来创建 Node 对象:

{

"kind": "Node",

"apiVersion": "v1",

"metadata": {

"name": "10.240.79.157",

"labels": {

"name": "my-first-k8s-node"

}

}

}

Kubernetes 会在内部创建一个 Node 对象作为节点的表示。Kubernetes 检查 kubelet

向 API 服务器注册节点时使用的 metadata.name 字段是否匹配。

如果节点是健康的(即所有必要的服务都在运行中),则该节点可以用来运行 Pod。

否则,直到该节点变为健康之前,所有的集群活动都会忽略该节点。

Node 对象的名称必须是合法的 DNS 子域名。

节点自注册

当 kubelet 标志 --register-node 为 true(默认)时,它会尝试向 API 服务注册自己。

这是首选模式,被绝大多数发行版选用。

对于自注册模式,kubelet 使用下列参数启动:

--kubeconfig- 用于向 API 服务器表明身份的凭据路径。--cloud-provider- 与某云驱动 进行通信以读取与自身相关的元数据的方式。--register-node- 自动向 API 服务注册。--register-with-taints- 使用所给的污点列表(逗号分隔的<key>=<value>:<effect>)注册节点。 当register-node为 false 时无效。--node-ip- 节点 IP 地址。--node-labels- 在集群中注册节点时要添加的 标签。 (参见 NodeRestriction 准入控制插件所实施的标签限制)。--node-status-update-frequency- 指定 kubelet 向控制面发送状态的频率。

启用节点授权模式和

NodeRestriction 准入插件

时,仅授权 kubelet 创建或修改其自己的节点资源。

手动节点管理

你可以使用 kubectl 来创建和修改 Node 对象。

如果你希望手动创建节点对象时,请设置 kubelet 标志 --register-node=false。

你可以修改 Node 对象(忽略 --register-node 设置)。

例如,修改节点上的标签或标记其为不可调度。

你可以结合使用节点上的标签和 Pod 上的选择算符来控制调度。 例如,你可以限制某 Pod 只能在符合要求的节点子集上运行。

如果标记节点为不可调度(unschedulable),将阻止新 Pod 调度到该节点之上,但不会 影响任何已经在其上的 Pod。 这是重启节点或者执行其他维护操作之前的一个有用的准备步骤。

要标记一个节点为不可调度,执行以下命令:

kubectl cordon $NODENAME

更多细节参考安全腾空节点。

节点状态

一个节点的状态包含以下信息:

你可以使用 kubectl 来查看节点状态和其他细节信息:

kubectl describe node <节点名称>

下面对每个部分进行详细描述。

地址

这些字段的用法取决于你的云服务商或者物理机配置。

- HostName:由节点的内核设置。可以通过 kubelet 的

--hostname-override参数覆盖。 - ExternalIP:通常是节点的可外部路由(从集群外可访问)的 IP 地址。

- InternalIP:通常是节点的仅可在集群内部路由的 IP 地址。

状况

conditions 字段描述了所有 Running 节点的状态。状况的示例包括:

| 节点状况 | 描述 |

|---|---|

Ready |

如节点是健康的并已经准备好接收 Pod 则为 True;False 表示节点不健康而且不能接收 Pod;Unknown 表示节点控制器在最近 node-monitor-grace-period 期间(默认 40 秒)没有收到节点的消息 |

DiskPressure |

True 表示节点存在磁盘空间压力,即磁盘可用量低, 否则为 False |

MemoryPressure |

True 表示节点存在内存压力,即节点内存可用量低,否则为 False |

PIDPressure |

True 表示节点存在进程压力,即节点上进程过多;否则为 False |

NetworkUnavailable |

True 表示节点网络配置不正确;否则为 False |

SchedulingDisabled。SchedulingDisabled 不是 Kubernetes API 中定义的

Condition,被保护起来的节点在其规约中被标记为不可调度(Unschedulable)。

在 Kubernetes API 中,节点的状况表示节点资源中.status 的一部分。

例如,以下 JSON 结构描述了一个健康节点:

"conditions": [

{

"type": "Ready",

"status": "True",

"reason": "KubeletReady",

"message": "kubelet is posting ready status",

"lastHeartbeatTime": "2019-06-05T18:38:35Z",

"lastTransitionTime": "2019-06-05T11:41:27Z"

}

]

如果 Ready 条件的 status 处于 Unknown 或者 False 状态的时间超过了 pod-eviction-timeout 值,

(一个传递给 kube-controller-manager 的参数),

节点控制器 会对节点上的所有 Pod 触发

API-发起的驱逐。

默认的逐出超时时长为 5 分钟。

某些情况下,当节点不可达时,API 服务器不能和其上的 kubelet 通信。

删除 Pod 的决定不能传达给 kubelet,直到它重新建立和 API 服务器的连接为止。

与此同时,被计划删除的 Pod 可能会继续在游离的节点上运行。

节点控制器在确认 Pod 在集群中已经停止运行前,不会强制删除它们。

你可以看到这些可能在无法访问的节点上运行的 Pod 处于 Terminating 或者 Unknown 状态。

如果 kubernetes 不能基于下层基础设施推断出某节点是否已经永久离开了集群,

集群管理员可能需要手动删除该节点对象。

从 Kubernetes 删除节点对象将导致 API 服务器删除节点上所有运行的 Pod 对象并释放它们的名字。

节点生命周期控制器会自动创建代表状况的 污点。 当调度器将 Pod 指派给某节点时,会考虑节点上的污点。 Pod 则可以通过容忍度(Toleration)表达所能容忍的污点。

容量与可分配

描述节点上的可用资源:CPU、内存和可以调度到节点上的 Pod 的个数上限。

capacity 块中的字段标示节点拥有的资源总量。

allocatable 块指示节点上可供普通 Pod 消耗的资源量。

可以在学习如何在节点上预留计算资源 的时候了解有关容量和可分配资源的更多信息。

信息

描述节点的一般信息,如内核版本、Kubernetes 版本(kubelet 和 kube-proxy 版本)、

容器运行时详细信息,以及 节点使用的操作系统。

kubelet 从节点收集这些信息并将其发布到 Kubernetes API。

心跳

Kubernetes 节点发送的心跳帮助你的集群确定每个节点的可用性,并在检测到故障时采取行动。

对于节点,有两种形式的心跳:

与 Node 的 .status 更新相比,Lease 是一种轻量级资源。

使用 Leases 心跳在大型集群中可以减少这些更新对性能的影响。

kubelet 负责创建和更新节点的 .status,以及更新它们对应的 Lease。

- 当状态发生变化时,或者在配置的时间间隔内没有更新事件时,kubelet 会更新

.status。.status更新的默认间隔为 5 分钟(比不可达节点的 40 秒默认超时时间长很多)。 kubelet会每 10 秒(默认更新间隔时间)创建并更新其Lease对象。Lease更新独立于NodeStatus更新而发生。 如果Lease的更新操作失败,kubelet会采用指数回退机制,从 200 毫秒开始 重试,最长重试间隔为 7 秒钟。

节点控制器

节点控制器是 Kubernetes 控制面组件,管理节点的方方面面。

节点控制器在节点的生命周期中扮演多个角色。 第一个是当节点注册时为它分配一个 CIDR 区段(如果启用了 CIDR 分配)。

第二个是保持节点控制器内的节点列表与云服务商所提供的可用机器列表同步。 如果在云环境下运行,只要某节点不健康,节点控制器就会询问云服务是否节点的虚拟机仍可用。 如果不可用,节点控制器会将该节点从它的节点列表删除。

第三个是监控节点的健康状况。 节点控制器是负责:

- 在节点节点不可达的情况下,在 Node 的

.status中更新NodeReady状况。 在这种情况下,节点控制器将NodeReady状况更新为ConditionUnknown。 - 如果节点仍然无法访问:对于不可达节点上的所有 Pod触发

API-发起的逐出。

默认情况下,节点控制器 在将节点标记为

ConditionUnknown后等待 5 分钟 提交第一个驱逐请求。

节点控制器每隔 --node-monitor-period 秒检查每个节点的状态。

逐出速率限制

大部分情况下,节点控制器把逐出速率限制在每秒 --node-eviction-rate 个(默认为 0.1)。

这表示它每 10 秒钟内至多从一个节点驱逐 Pod。

当一个可用区域(Availability Zone)中的节点变为不健康时,节点的驱逐行为将发生改变。

节点控制器会同时检查可用区域中不健康(NodeReady 状况为 ConditionUnknown 或 ConditionFalse)

的节点的百分比:

- 如果不健康节点的比例超过

--unhealthy-zone-threshold(默认为 0.55), 驱逐速率将会降低。 - 如果集群较小(意即小于等于

--large-cluster-size-threshold个节点 - 默认为 50),驱逐操作将会停止。 - 否则驱逐速率将降为每秒

--secondary-node-eviction-rate个(默认为 0.01)。

在单个可用区域实施这些策略的原因是当一个可用区域可能从控制面脱离时其它可用区域 可能仍然保持连接。 如果你的集群没有跨越云服务商的多个可用区域,那(整个集群)就只有一个可用区域。

跨多个可用区域部署你的节点的一个关键原因是当某个可用区域整体出现故障时,

工作负载可以转移到健康的可用区域。

因此,如果一个可用区域中的所有节点都不健康时,节点控制器会以正常的速率

--node-eviction-rate 进行驱逐操作。

在所有的可用区域都不健康(也即集群中没有健康节点)的极端情况下,

节点控制器将假设控制面与节点间的连接出了某些问题,它将停止所有驱逐动作(如果故障后部分节点重新连接,

节点控制器会从剩下不健康或者不可达节点中驱逐 pods)。

节点控制器还负责驱逐运行在拥有 NoExecute 污点的节点上的 Pod,

除非这些 Pod 能够容忍此污点。

节点控制器还负责根据节点故障(例如节点不可访问或没有就绪)为其添加

污点。

这意味着调度器不会将 Pod 调度到不健康的节点上。

资源容量跟踪

Node 对象会跟踪节点上资源的容量(例如可用内存和 CPU 数量)。 通过自注册机制生成的 Node 对象会在注册期间报告自身容量。 如果你手动添加了 Node,你就需要在添加节点时 手动设置节点容量。

Kubernetes 调度器保证节点上

有足够的资源供其上的所有 Pod 使用。它会检查节点上所有容器的请求的总和不会超过节点的容量。

总的请求包括由 kubelet 启动的所有容器,但不包括由容器运行时直接启动的容器,

也不包括不受 kubelet 控制的其他进程。

节点拓扑

Kubernetes v1.16 [alpha]

如果启用了 TopologyManager 特性门控,

kubelet 可以在作出资源分配决策时使用拓扑提示。

参考控制节点上拓扑管理策略

了解详细信息。

节点体面关闭

Kubernetes v1.21 [beta]

kubelet 会尝试检测节点系统关闭事件并终止在节点上运行的 Pods。

在节点终止期间,kubelet 保证 Pod 遵从常规的 Pod 终止流程。

体面节点关闭特性依赖于 systemd,因为它要利用 systemd 抑制器锁 在给定的期限内延迟节点关闭。

体面节点关闭特性受 GracefulNodeShutdown

特性门控

控制,在 1.21 版本中是默认启用的。

注意,默认情况下,下面描述的两个配置选项,ShutdownGracePeriod 和

ShutdownGracePeriodCriticalPods 都是被设置为 0 的,因此不会激活

体面节点关闭功能。

要激活此功能特性,这两个 kubelet 配置选项要适当配置,并设置为非零值。

在体面关闭节点过程中,kubelet 分两个阶段来终止 Pods:

- 终止在节点上运行的常规 Pod。

- 终止在节点上运行的关键 Pod。

节点体面关闭的特性对应两个

KubeletConfiguration 选项:

ShutdownGracePeriod:- 指定节点应延迟关闭的总持续时间。此时间是 Pod 体面终止的时间总和,不区分常规 Pod 还是 关键 Pod。

ShutdownGracePeriodCriticalPods:- 在节点关闭期间指定用于终止

关键 Pod

的持续时间。该值应小于

ShutdownGracePeriod。

- 在节点关闭期间指定用于终止

关键 Pod

的持续时间。该值应小于

例如,如果设置了 ShutdownGracePeriod=30s 和 ShutdownGracePeriodCriticalPods=10s,

则 kubelet 将延迟 30 秒关闭节点。

在关闭期间,将保留前 20(30 - 10)秒用于体面终止常规 Pod,

而保留最后 10 秒用于终止

关键 Pod。

当 Pod 在正常节点关闭期间被驱逐时,它们会被标记为 failed。

运行 kubectl get pods 将被驱逐的 pod 的状态显示为 Shutdown。

并且 kubectl describe pod 表示 pod 因节点关闭而被驱逐:

Status: Failed

Reason: Shutdown

Message: Node is shutting, evicting pods

Failed 的 pod 对象将被保留,直到被明确删除或

由 GC 清理。

与突然的节点终止相比这是一种行为变化。

交换内存管理

Kubernetes v1.22 [alpha]

在 Kubernetes 1.22 之前,节点不支持使用交换内存,并且 默认情况下,如果在节点上检测到交换内存配置,kubelet 将无法启动。 在 1.22 以后,可以在每个节点的基础上启用交换内存支持。

要在节点上启用交换内存,必须启用kubelet 的 NodeSwap 特性门控,

同时使用 --fail-swap-on 命令行参数或者将 failSwapOn

配置

设置为false。

用户还可以选择配置 memorySwap.swapBehavior 以指定节点使用交换内存的方式。 例如:

memorySwap:

swapBehavior: LimitedSwap

已有的 swapBehavior 的配置选项有:

LimitedSwap:Kubernetes 工作负载的交换内存会受限制。 不受 Kubernetes 管理的节点上的工作负载仍然可以交换。UnlimitedSwap:Kubernetes 工作负载可以使用尽可能多的交换内存 请求,一直到系统限制。

如果启用了特性门控但是未指定 memorySwap 的配置,默认情况下 kubelet 将使用

LimitedSwap 设置。

LimitedSwap 设置的行为还取决于节点运行的是 v1 还是 v2 的控制组(也就是 cgroups):

- cgroupsv1: Kubernetes 工作负载可以使用内存和 交换,达到 pod 的内存限制(如果设置)。

- cgroupsv2: Kubernetes 工作负载不能使用交换内存。

如需更多信息以及协助测试和提供反馈,请 参见 KEP-2400 及其 设计方案。

接下来

- 了解有关节点组件。

- 阅读 Node 的 API 定义。

- 阅读架构设计文档中有关 节点 的章节。

- 了解污点和容忍度。

2.2 - 控制面到节点通信

本文列举控制面节点(确切说是 API 服务器)和 Kubernetes 集群之间的通信路径。 目的是为了让用户能够自定义他们的安装,以实现对网络配置的加固,使得集群能够在不可信的网络上 (或者在一个云服务商完全公开的 IP 上)运行。

节点到控制面

Kubernetes 采用的是中心辐射型(Hub-and-Spoke)API 模式。 所有从集群(或所运行的 Pods)发出的 API 调用都终止于 apiserver。 其它控制面组件都没有被设计为可暴露远程服务。 apiserver 被配置为在一个安全的 HTTPS 端口(通常为 443)上监听远程连接请求, 并启用一种或多种形式的客户端身份认证机制。 一种或多种客户端鉴权机制应该被启用, 特别是在允许使用匿名请求 或服务账号令牌的时候。

应该使用集群的公共根证书开通节点,这样它们就能够基于有效的客户端凭据安全地连接 apiserver。 一种好的方法是以客户端证书的形式将客户端凭据提供给 kubelet。 请查看 kubelet TLS 启动引导 以了解如何自动提供 kubelet 客户端证书。

想要连接到 apiserver 的 Pod 可以使用服务账号安全地进行连接。

当 Pod 被实例化时,Kubernetes 自动把公共根证书和一个有效的持有者令牌注入到 Pod 里。

kubernetes 服务(位于 default 名字空间中)配置了一个虚拟 IP 地址,用于(通过 kube-proxy)转发

请求到 apiserver 的 HTTPS 末端。

控制面组件也通过安全端口与集群的 apiserver 通信。

这样,从集群节点和节点上运行的 Pod 到控制面的连接的缺省操作模式即是安全的, 能够在不可信的网络或公网上运行。

控制面到节点

从控制面(apiserver)到节点有两种主要的通信路径。 第一种是从 apiserver 到集群中每个节点上运行的 kubelet 进程。 第二种是从 apiserver 通过它的代理功能连接到任何节点、Pod 或者服务。

API 服务器到 kubelet

从 apiserver 到 kubelet 的连接用于:

- 获取 Pod 日志

- 挂接(通过 kubectl)到运行中的 Pod

- 提供 kubelet 的端口转发功能。

这些连接终止于 kubelet 的 HTTPS 末端。 默认情况下,apiserver 不检查 kubelet 的服务证书。这使得此类连接容易受到中间人攻击, 在非受信网络或公开网络上运行也是 不安全的。

为了对这个连接进行认证,使用 --kubelet-certificate-authority 标志给 apiserver

提供一个根证书包,用于 kubelet 的服务证书。

如果无法实现这点,又要求避免在非受信网络或公共网络上进行连接,可在 apiserver 和 kubelet 之间使用 SSH 隧道。

最后,应该启用 kubelet 用户认证和/或鉴权 来保护 kubelet API。

apiserver 到节点、Pod 和服务

从 apiserver 到节点、Pod 或服务的连接默认为纯 HTTP 方式,因此既没有认证,也没有加密。

这些连接可通过给 API URL 中的节点、Pod 或服务名称添加前缀 https: 来运行在安全的 HTTPS 连接上。

不过这些连接既不会验证 HTTPS 末端提供的证书,也不会提供客户端证书。

因此,虽然连接是加密的,仍无法提供任何完整性保证。

这些连接 目前还不能安全地 在非受信网络或公共网络上运行。

SSH 隧道

Kubernetes 支持使用 SSH 隧道来保护从控制面到节点的通信路径。在这种配置下,apiserver 建立一个到集群中各节点的 SSH 隧道(连接到在 22 端口监听的 SSH 服务) 并通过这个隧道传输所有到 kubelet、节点、Pod 或服务的请求。 这一隧道保证通信不会被暴露到集群节点所运行的网络之外。

SSH 隧道目前已被废弃。除非你了解个中细节,否则不应使用。 Konnectivity 服务是对此通信通道的替代品。

Konnectivity 服务

Kubernetes v1.18 [beta]

作为 SSH 隧道的替代方案,Konnectivity 服务提供 TCP 层的代理,以便支持从控制面到集群的通信。 Konnectivity 服务包含两个部分:Konnectivity 服务器和 Konnectivity 代理,分别运行在 控制面网络和节点网络中。Konnectivity 代理建立并维持到 Konnectivity 服务器的网络连接。 启用 Konnectivity 服务之后,所有控制面到节点的通信都通过这些连接传输。

请浏览 Konnectivity 服务任务 在你的集群中配置 Konnectivity 服务。

2.3 - 控制器

在机器人技术和自动化领域,控制回路(Control Loop)是一个非终止回路,用于调节系统状态。

这是一个控制环的例子:房间里的温度自动调节器。

当你设置了温度,告诉了温度自动调节器你的期望状态(Desired State)。 房间的实际温度是当前状态(Current State)。 通过对设备的开关控制,温度自动调节器让其当前状态接近期望状态。

在 Kubernetes 中,控制器通过监控集群 的公共状态,并致力于将当前状态转变为期望的状态。控制器模式

一个控制器至少追踪一种类型的 Kubernetes 资源。这些

对象

有一个代表期望状态的 spec 字段。

该资源的控制器负责确保其当前状态接近期望状态。

控制器可能会自行执行操作;在 Kubernetes 中更常见的是一个控制器会发送信息给 API 服务器,这会有副作用。 具体可参看后文的例子。

通过 API 服务器来控制

Job 控制器是一个 Kubernetes 内置控制器的例子。 内置控制器通过和集群 API 服务器交互来管理状态。

Job 是一种 Kubernetes 资源,它运行一个或者多个 Pod,

来执行一个任务然后停止。

(一旦被调度了,对 kubelet 来说 Pod

对象就会变成了期望状态的一部分)。

在集群中,当 Job 控制器拿到新任务时,它会保证一组 Node 节点上的 kubelet

可以运行正确数量的 Pod 来完成工作。

Job 控制器不会自己运行任何的 Pod 或者容器。Job 控制器是通知 API 服务器来创建或者移除 Pod。

控制面中的其它组件

根据新的消息作出反应(调度并运行新 Pod)并且最终完成工作。

创建新 Job 后,所期望的状态就是完成这个 Job。Job 控制器会让 Job 的当前状态不断接近期望状态:创建为 Job 要完成工作所需要的 Pod,使 Job 的状态接近完成。

控制器也会更新配置对象。例如:一旦 Job 的工作完成了,Job 控制器会更新 Job 对象的状态为 Finished。

(这有点像温度自动调节器关闭了一个灯,以此来告诉你房间的温度现在到你设定的值了)。

直接控制

相比 Job 控制器,有些控制器需要对集群外的一些东西进行修改。

例如,如果你使用一个控制回路来保证集群中有足够的 节点,那么控制器就需要当前集群外的 一些服务在需要时创建新节点。

和外部状态交互的控制器从 API 服务器获取到它想要的状态,然后直接和外部系统进行通信 并使当前状态更接近期望状态。

(实际上有一个控制器 可以水平地扩展集群中的节点。)

这里,很重要的一点是,控制器做出了一些变更以使得事物更接近你的期望状态, 之后将当前状态报告给集群的 API 服务器。 其他控制回路可以观测到所汇报的数据的这种变化并采取其各自的行动。

在温度计的例子中,如果房间很冷,那么某个控制器可能还会启动一个防冻加热器。 就 Kubernetes 集群而言,控制面间接地与 IP 地址管理工具、存储服务、云驱动 APIs 以及其他服务协作,通过扩展 Kubernetes 来实现这点。

期望状态与当前状态

Kubernetes 采用了系统的云原生视图,并且可以处理持续的变化。

在任务执行时,集群随时都可能被修改,并且控制回路会自动修复故障。 这意味着很可能集群永远不会达到稳定状态。

只要集群中的控制器在运行并且进行有效的修改,整体状态的稳定与否是无关紧要的。

设计

作为设计原则之一,Kubernetes 使用了很多控制器,每个控制器管理集群状态的一个特定方面。 最常见的一个特定的控制器使用一种类型的资源作为它的期望状态, 控制器管理控制另外一种类型的资源向它的期望状态演化。

使用简单的控制器而不是一组相互连接的单体控制回路是很有用的。 控制器会失败,所以 Kubernetes 的设计正是考虑到了这一点。

可以有多个控制器来创建或者更新相同类型的对象。 在后台,Kubernetes 控制器确保它们只关心与其控制资源相关联的资源。

例如,你可以创建 Deployment 和 Job;它们都可以创建 Pod。 Job 控制器不会删除 Deployment 所创建的 Pod,因为有信息 (标签)让控制器可以区分这些 Pod。

运行控制器的方式

Kubernetes 内置一组控制器,运行在 kube-controller-manager 内。 这些内置的控制器提供了重要的核心功能。

Deployment 控制器和 Job 控制器是 Kubernetes 内置控制器的典型例子。 Kubernetes 允许你运行一个稳定的控制平面,这样即使某些内置控制器失败了, 控制平面的其他部分会接替它们的工作。

你会遇到某些控制器运行在控制面之外,用以扩展 Kubernetes。 或者,如果你愿意,你也可以自己编写新控制器。 你可以以一组 Pod 来运行你的控制器,或者运行在 Kubernetes 之外。 最合适的方案取决于控制器所要执行的功能是什么。

接下来

- 阅读 Kubernetes 控制平面组件

- 了解 Kubernetes 对象 的一些基本知识

- 进一步学习 Kubernetes API

- 如果你想编写自己的控制器,请看 Kubernetes 的 扩展模式。

2.4 - 云控制器管理器

Kubernetes v1.11 [beta]

使用云基础设施技术,你可以在公有云、私有云或者混合云环境中运行 Kubernetes。 Kubernetes 的信条是基于自动化的、API 驱动的基础设施,同时避免组件间紧密耦合。

组件 cloud-controller-manager 是指云控制器管理器, 云控制器管理器是指嵌入特定云的控制逻辑的 控制平面组件。 云控制器管理器使得你可以将你的集群连接到云提供商的 API 之上, 并将与该云平台交互的组件同与你的集群交互的组件分离开来。

通过分离 Kubernetes 和底层云基础设置之间的互操作性逻辑, 云控制器管理器组件使云提供商能够以不同于 Kubernetes 主项目的 步调发布新特征。

cloud-controller-manager 组件是基于一种插件机制来构造的,

这种机制使得不同的云厂商都能将其平台与 Kubernetes 集成。

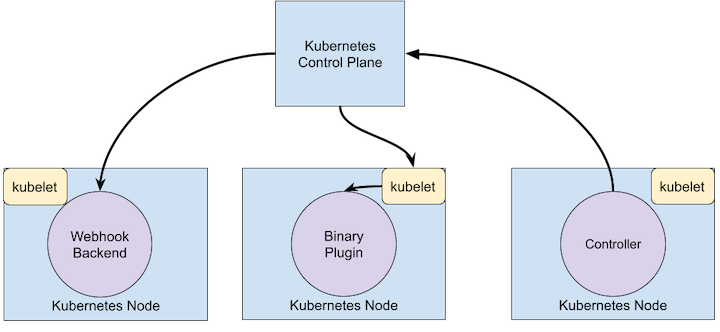

设计

云控制器管理器以一组多副本的进程集合的形式运行在控制面中,通常表现为 Pod

中的容器。每个 cloud-controller-manager 在同一进程中实现多个

控制器。

云控制器管理器的功能

云控制器管理器中的控制器包括:

节点控制器

节点控制器负责在云基础设施中创建了新服务器时为之 更新 节点(Node)对象。 节点控制器从云提供商获取当前租户中主机的信息。节点控制器执行以下功能:

- 使用从云平台 API 获取的对应服务器的唯一标识符更新 Node 对象;

- 利用特定云平台的信息为 Node 对象添加注解和标签,例如节点所在的 区域(Region)和所具有的资源(CPU、内存等等);

- 获取节点的网络地址和主机名;

- 检查节点的健康状况。如果节点无响应,控制器通过云平台 API 查看该节点是否 已从云中禁用、删除或终止。如果节点已从云中删除,则控制器从 Kubernetes 集群 中删除 Node 对象。

某些云驱动实现中,这些任务被划分到一个节点控制器和一个节点生命周期控制器中。

路由控制器

Route 控制器负责适当地配置云平台中的路由,以便 Kubernetes 集群中不同节点上的 容器之间可以相互通信。

取决于云驱动本身,路由控制器可能也会为 Pod 网络分配 IP 地址块。

服务控制器

服务(Service)与受控的负载均衡器、 IP 地址、网络包过滤、目标健康检查等云基础设施组件集成。 服务控制器与云驱动的 API 交互,以配置负载均衡器和其他基础设施组件。 你所创建的 Service 资源会需要这些组件服务。

鉴权

本节分别讲述云控制器管理器为了完成自身工作而产生的对各类 API 对象的访问需求。

节点控制器

节点控制器只操作 Node 对象。它需要读取和修改 Node 对象的完全访问权限。

v1/Node:

- Get

- List

- Create

- Update

- Patch

- Watch

- Delete

路由控制器

路由控制器会监听 Node 对象的创建事件,并据此配置路由设施。 它需要读取 Node 对象的 Get 权限。

v1/Node:

- Get

服务控制器

服务控制器监测 Service 对象的 Create、Update 和 Delete 事件,并配置 对应服务的 Endpoints 对象。 为了访问 Service 对象,它需要 List、Watch 访问权限;为了更新 Service 对象 它需要 Patch 和 Update 访问权限。 为了能够配置 Service 对应的 Endpoints 资源,它需要 Create、List、Get、Watch 和 Update 等访问权限。

v1/Service:

- List

- Get

- Watch

- Patch

- Update

其他

云控制器管理器的实现中,其核心部分需要创建 Event 对象的访问权限以及 创建 ServiceAccount 资源以保证操作安全性的权限。

v1/Event:

- Create

- Patch

- Update

v1/ServiceAccount:

- Create

用于云控制器管理器 RBAC 的 ClusterRole 如下例所示:

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: cloud-controller-manager

rules:

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- update

- apiGroups:

- ""

resources:

- nodes

verbs:

- '*'

- apiGroups:

- ""

resources:

- nodes/status

verbs:

- patch

- apiGroups:

- ""

resources:

- services

verbs:

- list

- patch

- update

- watch

- apiGroups:

- ""

resources:

- serviceaccounts

verbs:

- create

- apiGroups:

- ""

resources:

- persistentvolumes

verbs:

- get

- list

- update

- watch

- apiGroups:

- ""

resources:

- endpoints

verbs:

- create

- get

- list

- watch

- update

接下来

云控制器管理器的管理 给出了运行和管理云控制器管理器的指南。

要升级 HA 控制平面以使用云控制器管理器,请参见 将复制的控制平面迁移以使用云控制器管理器

想要了解如何实现自己的云控制器管理器,或者对现有项目进行扩展么?

云控制器管理器使用 Go 语言的接口,从而使得针对各种云平台的具体实现都可以接入。

其中使用了在 kubernetes/cloud-provider

项目中 cloud.go

文件所定义的 CloudProvider 接口。

本文中列举的共享控制器(节点控制器、路由控制器和服务控制器等)的实现以及

其他一些生成具有 CloudProvider 接口的框架的代码,都是 Kubernetes 的核心代码。

特定于云驱动的实现虽不是 Kubernetes 核心成分,仍要实现 CloudProvider 接口。

关于如何开发插件的详细信息,可参考 开发云控制器管理器 文档。

3 - 容器

每个运行的容器都是可重复的; 包含依赖环境在内的标准,意味着无论您在哪里运行它,您都会得到相同的行为。

容器将应用程序从底层的主机设施中解耦。 这使得在不同的云或 OS 环境中部署更加容易。

容器镜像

容器镜像是一个随时可以运行的软件包, 包含运行应用程序所需的一切:代码和它需要的所有运行时、应用程序和系统库,以及一些基本设置的默认值。

根据设计,容器是不可变的:你不能更改已经运行的容器的代码。 如果有一个容器化的应用程序需要修改,则需要构建包含更改的新镜像,然后再基于新构建的镜像重新运行容器。

容器运行时

容器运行环境是负责运行容器的软件。

Kubernetes 支持多个容器运行环境: Docker、 containerd、CRI-O 以及任何实现 Kubernetes CRI (容器运行环境接口)。

接下来

3.1 - 镜像

容器镜像(Image)所承载的是封装了应用程序及其所有软件依赖的二进制数据。 容器镜像是可执行的软件包,可以单独运行;该软件包对所处的运行时环境具有 良定(Well Defined)的假定。

你通常会创建应用的容器镜像并将其推送到某仓库(Registry),然后在 Pod 中引用它。

本页概要介绍容器镜像的概念。

镜像名称

容器镜像通常会被赋予 pause、example/mycontainer 或者 kube-apiserver 这类的名称。

镜像名称也可以包含所在仓库的主机名。例如:fictional.registry.example/imagename。

还可以包含仓库的端口号,例如:fictional.registry.example:10443/imagename。

如果你不指定仓库的主机名,Kubernetes 认为你在使用 Docker 公共仓库。

在镜像名称之后,你可以添加一个 标签(Tag) (就像在 docker 或 podman

中也在用的那样)。

使用标签能让你辨识同一镜像序列中的不同版本。

镜像标签可以包含小写字母、大写字母、数字、下划线(_)、句点(.)和连字符(-)。

关于在镜像标签中何处可以使用分隔字符(_、- 和 .)还有一些额外的规则。

如果你不指定标签,Kubernetes 认为你想使用标签 latest。

更新镜像

当你最初创建一个 Deployment、

StatefulSet、Pod

或者其他包含 Pod 模板的对象时,如果没有显式设定的话,Pod 中所有容器的默认镜像

拉取策略是 IfNotPresent。这一策略会使得

kubelet

在镜像已经存在的情况下直接略过拉取镜像的操作。

镜像拉取策略

容器的 imagePullPolicy 和镜像的标签会影响 kubelet 尝试拉取(下载)指定的镜像。

以下列表包含了 imagePullPolicy 可以设置的值,以及这些值的效果:

IfNotPresent- 只有当镜像在本地不存在时才会拉取。

Always- 每当 kubelet 启动一个容器时,kubelet 会查询容器的镜像仓库, 将名称解析为一个镜像摘要。 如果 kubelet 有一个容器镜像,并且对应的摘要已在本地缓存,kubelet 就会使用其缓存的镜像; 否则,kubelet 就会使用解析后的摘要拉取镜像,并使用该镜像来启动容器。

Never- Kubelet 不会尝试获取镜像。如果镜像已经以某种方式存在本地, kubelet 会尝试启动容器;否则,会启动失败。 更多细节见提前拉取镜像。

只要能够可靠地访问镜像仓库,底层镜像提供者的缓存语义甚至可以使 imagePullPolicy: Always 高效。

你的容器运行时可以注意到节点上已经存在的镜像层,这样就不需要再次下载。

在生产环境中部署容器时,你应该避免使用 :latest 标签,因为这使得正在运行的镜像的版本难以追踪,并且难以正确地回滚。

相反,应指定一个有意义的标签,如 v1.42.0。

为了确保 Pod 总是使用相同版本的容器镜像,你可以指定镜像的摘要;

将 <image-name>:<tag> 替换为 <image-name>@<digest>,例如 image@sha256:45b23dee08af5e43a7fea6c4cf9c25ccf269ee113168c19722f87876677c5cb2。

当使用镜像标签时,如果镜像仓库修改了代码所对应的镜像标签,可能会出现新旧代码混杂在 Pod 中运行的情况。 镜像摘要唯一标识了镜像的特定版本,因此 Kubernetes 每次启动具有指定镜像名称和摘要的容器时,都会运行相同的代码。 指定一个镜像可以固定你所运行的代码,这样镜像仓库的变化就不会导致版本的混杂。

有一些第三方的准入控制器 在创建 Pod(和 Pod 模板)时产生变更,这样运行的工作负载就是根据镜像摘要,而不是标签来定义的。 无论镜像仓库上的标签发生什么变化,你都想确保你所有的工作负载都运行相同的代码,那么指定镜像摘要会很有用。

默认镜像拉取策略

当你(或控制器)向 API 服务器提交一个新的 Pod 时,你的集群会在满足特定条件时设置 imagePullPolicy 字段:

- 如果你省略了

imagePullPolicy字段,并且容器镜像的标签是:latest,imagePullPolicy会自动设置为Always。 - 如果你省略了

imagePullPolicy字段,并且没有指定容器镜像的标签,imagePullPolicy会自动设置为Always。 - 如果你省略了

imagePullPolicy字段,并且为容器镜像指定了非:latest的标签,imagePullPolicy就会自动设置为IfNotPresent。

容器的 imagePullPolicy 的值总是在对象初次 创建 时设置的,如果后来镜像的标签发生变化,则不会更新。

例如,如果你用一个 非 :latest 的镜像标签创建一个 Deployment,

并在随后更新该 Deployment 的镜像标签为 :latest,则 imagePullPolicy 字段 不会 变成 Always。

你必须手动更改已经创建的资源的拉取策略。

必要的镜像拉取

如果你想总是强制执行拉取,你可以使用下述的一中方式:

- 设置容器的

imagePullPolicy为Always。 - 省略

imagePullPolicy,并使用:latest作为镜像标签; 当你提交 Pod 时,Kubernetes 会将策略设置为Always。 - 省略

imagePullPolicy和镜像的标签; 当你提交 Pod 时,Kubernetes 会将策略设置为Always。 - 启用准入控制器 AlwaysPullImages。

ImagePullBackOff

当 kubelet 使用容器运行时创建 Pod 时,容器可能因为 ImagePullBackOff 导致状态为

Waiting。

ImagePullBackOff 状态意味着容器无法启动,

因为 Kubernetes 无法拉取容器镜像(原因包括无效的镜像名称,或从私有仓库拉取而没有 imagePullSecret)。

BackOff 部分表示 Kubernetes 将继续尝试拉取镜像,并增加回退延迟。

Kubernetes 会增加每次尝试之间的延迟,直到达到编译限制,即 300 秒(5 分钟)。

带镜像索引的多架构镜像

除了提供二进制的镜像之外,容器仓库也可以提供

容器镜像索引。

镜像索引可以根据特定于体系结构版本的容器指向镜像的多个

镜像清单。

这背后的理念是让你可以为镜像命名(例如:pause、example/mycontainer、kube-apiserver)

的同时,允许不同的系统基于它们所使用的机器体系结构取回正确的二进制镜像。

Kubernetes 自身通常在命名容器镜像时添加后缀 -$(ARCH)。

为了向前兼容,请在生成较老的镜像时也提供后缀。

这里的理念是为某镜像(如 pause)生成针对所有平台都适用的清单时,

生成 pause-amd64 这类镜像,以便较老的配置文件或者将镜像后缀影编码到其中的

YAML 文件也能兼容。

使用私有仓库

从私有仓库读取镜像时可能需要密钥。 凭证可以用以下方式提供:

- 配置节点向私有仓库进行身份验证

- 所有 Pod 均可读取任何已配置的私有仓库

- 需要集群管理员配置节点

- 预拉镜像

- 所有 Pod 都可以使用节点上缓存的所有镜像

- 需要所有节点的 root 访问权限才能进行设置

- 在 Pod 中设置 ImagePullSecrets

- 只有提供自己密钥的 Pod 才能访问私有仓库

- 特定于厂商的扩展或者本地扩展

- 如果你在使用定制的节点配置,你(或者云平台提供商)可以实现让节点 向容器仓库认证的机制

下面将详细描述每一项。

配置 Node 对私有仓库认证

如果你在节点上运行的是 Docker,你可以配置 Docker 容器运行时来向私有容器仓库认证身份。

此方法适用于能够对节点进行配置的场合。

auths 和 HttpHeaders 部分,

不支持 Docker 凭据辅助程序(credHelpers 或 credsStore)。

Docker 将私有仓库的密钥保存在 $HOME/.dockercfg 或 $HOME/.docker/config.json

文件中。如果你将相同的文件放在下面所列的搜索路径中,kubelet 会在拉取镜像时将其用作凭据

数据来源:

{--root-dir:-/var/lib/kubelet}/config.json{kubelet 当前工作目录}/config.json${HOME}/.docker/config.json/.docker/config.json{--root-dir:-/var/lib/kubelet}/.dockercfg{kubelet 当前工作目录}/.dockercfg${HOME}/.dockercfg/.dockercfg

kubelet 进程显式地设置 HOME=/root 环境变量。

推荐采用如下步骤来配置节点以便访问私有仓库。以下示例中,在 PC 或笔记本电脑中操作:

-

针对你要使用的每组凭据,运行

docker login [服务器]命令。这会更新 你本地环境中的$HOME/.docker/config.json文件。 -

在编辑器中打开查看

$HOME/.docker/config.json文件,确保其中仅包含你要 使用的凭据信息。 -

获得节点列表;例如:

-

如果想要节点名称:

nodes=$(kubectl get nodes -o jsonpath='{range.items[*].metadata}{.name} {end}') -

如果想要节点 IP ,

nodes=$(kubectl get nodes -o jsonpath='{range .items[*].status.addresses[?(@.type=="ExternalIP")]}{.address} {end}')

-

-

将本地的

.docker/config.json拷贝到所有节点,放入如上所列的目录之一:- 例如,可以试一下:

for n in $nodes; do scp ~/.docker/config.json root@"$n":/var/lib/kubelet/config.json; done

- 例如,可以试一下:

创建使用私有镜像的 Pod 来验证。例如:

kubectl apply -f - <<EOF

apiVersion: v1

kind: Pod

metadata:

name: private-image-test-1

spec:

containers:

- name: uses-private-image

image: $PRIVATE_IMAGE_NAME

imagePullPolicy: Always

command: [ "echo", "SUCCESS" ]

EOF

输出类似于:

pod/private-image-test-1 created

如果一切顺利,那么一段时间后你可以执行:

kubectl logs private-image-test-1

然后可以看到命令的输出:

SUCCESS

如果你怀疑命令失败了,你可以运行:

kubectl describe pods/private-image-test-1 | grep 'Failed'

如果命令确实失败,输出类似于:

Fri, 26 Jun 2015 15:36:13 -0700 Fri, 26 Jun 2015 15:39:13 -0700 19 {kubelet node-i2hq} spec.containers{uses-private-image} failed Failed to pull image "user/privaterepo:v1": Error: image user/privaterepo:v1 not found

你必须确保集群中所有节点的 .docker/config.json 文件内容相同。

否则,Pod 会能在一些节点上正常运行而无法在另一些节点上启动。

例如,如果使用节点自动扩缩,那么每个实例模板都需要包含 .docker/config.json,

或者挂载一个包含该文件的驱动器。

在 .docker/config.json 中配置了私有仓库密钥后,所有 Pod 都将能读取私有仓库中的镜像。

config.json 说明

对于 config.json 的解释在原始 Docker 实现和 Kubernetes 的解释之间有所不同。

在 Docker 中,auths 键只能指定根 URL ,而 Kubernetes 允许 glob URLs 以及

前缀匹配的路径。这意味着,像这样的 config.json 是有效的:

{

"auths": {

"*my-registry.io/images": {

"auth": "…"

}

}

}

使用以下语法匹配根 URL (*my-registry.io):

pattern:

{ term }

term:

'*' 匹配任何无分隔符字符序列

'?' 匹配任意单个非分隔符

'[' [ '^' ] 字符范围

字符集(必须非空)

c 匹配字符 c (c 不为 '*','?','\\','[')

'\\' c 匹配字符 c

字符范围:

c 匹配字符 c (c 不为 '\\','?','-',']')

'\\' c 匹配字符 c

lo '-' hi 匹配字符范围在 lo 到 hi 之间字符

现在镜像拉取操作会将每种有效模式的凭据都传递给 CRI 容器运行时。例如下面的容器镜像名称会匹配成功:

my-registry.io/imagesmy-registry.io/images/my-imagemy-registry.io/images/another-imagesub.my-registry.io/images/my-imagea.sub.my-registry.io/images/my-image

kubelet 为每个找到的凭证的镜像按顺序拉取。 这意味着在 config.json 中可能有多项:

{

"auths": {

"my-registry.io/images": {

"auth": "…"

},

"my-registry.io/images/subpath": {

"auth": "…"

}

}

}

如果一个容器指定了要拉取的镜像 my-registry.io/images/subpath/my-image,

并且其中一个失败,kubelet 将尝试从另一个身份验证源下载镜像。

提前拉取镜像

默认情况下,kubelet 会尝试从指定的仓库拉取每个镜像。

但是,如果容器属性 imagePullPolicy 设置为 IfNotPresent 或者 Never,

则会优先使用(对应 IfNotPresent)或者一定使用(对应 Never)本地镜像。

如果你希望使用提前拉取镜像的方法代替仓库认证,就必须保证集群中所有节点提前拉取的镜像是相同的。

这一方案可以用来提前载入指定的镜像以提高速度,或者作为向私有仓库执行身份认证的一种替代方案。

所有的 Pod 都可以使用节点上提前拉取的镜像。

在 Pod 上指定 ImagePullSecrets

Kubernetes 支持在 Pod 中设置容器镜像仓库的密钥。

使用 Docker Config 创建 Secret

运行以下命令,将大写字母代替为合适的值:

kubectl create secret docker-registry <名称> \

--docker-server=DOCKER_REGISTRY_SERVER \

--docker-username=DOCKER_USER \

--docker-password=DOCKER_PASSWORD \

--docker-email=DOCKER_EMAIL

如果你已经有 Docker 凭据文件,则可以将凭据文件导入为 Kubernetes Secret, 而不是执行上面的命令。 基于已有的 Docker 凭据创建 Secret 解释了如何完成这一操作。

如果你在使用多个私有容器仓库,这种技术将特别有用。

原因是 kubectl create secret docker-registry 创建的是仅适用于某个私有仓库的 Secret。

在 Pod 中引用 ImagePullSecrets

现在,在创建 Pod 时,可以在 Pod 定义中增加 imagePullSecrets 部分来引用该 Secret。

例如:

cat <<EOF > pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: foo

namespace: awesomeapps

spec:

containers:

- name: foo

image: janedoe/awesomeapp:v1

imagePullSecrets:

- name: myregistrykey

EOF

cat <<EOF >> ./kustomization.yaml

resources:

- pod.yaml

EOF

你需要对使用私有仓库的每个 Pod 执行以上操作。

不过,设置该字段的过程也可以通过为

服务账号

资源设置 imagePullSecrets 来自动完成。

有关详细指令可参见

将 ImagePullSecrets 添加到服务账号。

你也可以将此方法与节点级别的 .docker/config.json 配置结合使用。

来自不同来源的凭据会被合并。

使用案例

配置私有仓库有多种方案,以下是一些常用场景和建议的解决方案。

- 集群运行非专有镜像(例如,开源镜像)。镜像不需要隐藏。

- 使用 Docker hub 上的公开镜像

- 无需配置

- 某些云厂商会自动为公开镜像提供高速缓存,以便提升可用性并缩短拉取镜像所需时间

- 使用 Docker hub 上的公开镜像

- 集群运行一些专有镜像,这些镜像需要对公司外部隐藏,对所有集群用户可见

- 使用托管的私有 Docker 仓库。

- 可以托管在 Docker Hub 或者其他地方

- 按照上面的描述,在每个节点上手动配置

.docker/config.json文件

- 或者,在防火墙内运行一个组织内部的私有仓库,并开放读取权限

- 不需要配置 Kubenretes

- 使用控制镜像访问的托管容器镜像仓库服务

- 与手动配置节点相比,这种方案能更好地处理集群自动扩缩容

- 或者,在不方便更改节点配置的集群中,使用

imagePullSecrets

- 使用托管的私有 Docker 仓库。

- 集群使用专有镜像,且有些镜像需要更严格的访问控制

- 确保 AlwaysPullImages 准入控制器被启用。否则,所有 Pod 都可以使用所有镜像。

- 确保将敏感数据存储在 Secret 资源中,而不是将其打包在镜像里

- 集群是多租户的并且每个租户需要自己的私有仓库

- 确保 AlwaysPullImages 准入控制器。否则,所有租户的所有的 Pod 都可以使用所有镜像。

- 为私有仓库启用鉴权

- 为每个租户生成访问仓库的凭据,放置在 Secret 中,并将 Secrert 发布到各租户的命名空间下。

- 租户将 Secret 添加到每个名字空间中的 imagePullSecrets

如果你需要访问多个仓库,可以为每个仓库创建一个 Secret。

kubelet 将所有 imagePullSecrets 合并为一个虚拟的 .docker/config.json 文件。

接下来

- 阅读 OCI Image Manifest 规范。

- 了解容器镜像垃圾收集。

3.2 - 容器环境

本页描述了在容器环境里容器可用的资源。

容器环境

Kubernetes 的容器环境给容器提供了几个重要的资源:

容器信息

容器的 hostname 是它所运行在的 pod 的名称。它可以通过 hostname 命令或者调用 libc 中的

gethostname 函数来获取。

Pod 名称和命名空间可以通过 下行 API 转换为环境变量。

Pod 定义中的用户所定义的环境变量也可在容器中使用,就像在 Docker 镜像中静态指定的任何环境变量一样。

集群信息

创建容器时正在运行的所有服务都可用作该容器的环境变量。 这里的服务仅限于新容器的 Pod 所在的名字空间中的服务,以及 Kubernetes 控制面的服务。 这些环境变量与 Docker 链接的语法相同。

对于名为 foo 的服务,当映射到名为 bar 的容器时,以下变量是被定义了的:

FOO_SERVICE_HOST=<the host the service is running on>

FOO_SERVICE_PORT=<the port the service is running on>

服务具有专用的 IP 地址。如果启用了 DNS 插件, 可以在容器中通过 DNS 来访问服务。

接下来

- 学习更多有关容器生命周期回调的知识

- 动手为容器生命周期事件添加处理程序

3.3 - 容器运行时类(Runtime Class)

Kubernetes v1.20 [stable]

本页面描述了 RuntimeClass 资源和运行时的选择机制。

RuntimeClass 是一个用于选择容器运行时配置的特性,容器运行时配置用于运行 Pod 中的容器。

动机

你可以在不同的 Pod 设置不同的 RuntimeClass,以提供性能与安全性之间的平衡。 例如,如果你的部分工作负载需要高级别的信息安全保证,你可以决定在调度这些 Pod 时尽量使它们在使用硬件虚拟化的容器运行时中运行。 这样,你将从这些不同运行时所提供的额外隔离中获益,代价是一些额外的开销。

你还可以使用 RuntimeClass 运行具有相同容器运行时但具有不同设置的 Pod。

设置

- 在节点上配置 CRI 的实现(取决于所选用的运行时)

- 创建相应的 RuntimeClass 资源

1. 在节点上配置 CRI 实现

RuntimeClass 的配置依赖于 运行时接口(CRI)的实现。 根据你使用的 CRI 实现,查阅相关的文档(下方)来了解如何配置。

所有这些配置都具有相应的 handler 名,并被 RuntimeClass 引用。

handler 必须是有效的 DNS 标签名。

2. 创建相应的 RuntimeClass 资源

在上面步骤 1 中,每个配置都需要有一个用于标识配置的 handler。

针对每个 handler 需要创建一个 RuntimeClass 对象。

RuntimeClass 资源当前只有两个重要的字段:RuntimeClass 名 (metadata.name) 和 handler (handler)。

对象定义如下所示:

apiVersion: node.k8s.io/v1 # RuntimeClass 定义于 node.k8s.io API 组

kind: RuntimeClass

metadata:

name: myclass # 用来引用 RuntimeClass 的名字

# RuntimeClass 是一个集群层面的资源

handler: myconfiguration # 对应的 CRI 配置的名称

使用说明

一旦完成集群中 RuntimeClasses 的配置,使用起来非常方便。

在 Pod spec 中指定 runtimeClassName 即可。例如:

apiVersion: v1

kind: Pod

metadata:

name: mypod

spec:

runtimeClassName: myclass

# ...

这一设置会告诉 kubelet 使用所指的 RuntimeClass 来运行该 pod。

如果所指的 RuntimeClass 不存在或者 CRI 无法运行相应的 handler,

那么 pod 将会进入 Failed 终止阶段。

你可以查看相应的事件,

获取执行过程中的错误信息。

如果未指定 runtimeClassName ,则将使用默认的 RuntimeHandler,相当于禁用 RuntimeClass 功能特性。

CRI 配置

关于如何安装 CRI 运行时,请查阅 CRI 安装。

dockershim

为 dockershim 设置 RuntimeClass 时,必须将运行时处理程序设置为 docker。

Dockershim 不支持自定义的可配置的运行时处理程序。

containerd

通过 containerd 的 /etc/containerd/config.toml 配置文件来配置运行时 handler。

handler 需要配置在 runtimes 块中:

[plugins."io.containerd.grpc.v1.cri".containerd.runtimes.${HANDLER_NAME}]

更详细信息,请查阅 containerd 配置文档: https://github.com/containerd/cri/blob/master/docs/config.md

cri-o

通过 cri-o 的 /etc/crio/crio.conf 配置文件来配置运行时 handler。

handler 需要配置在

crio.runtime 表

下面:

[crio.runtime.runtimes.${HANDLER_NAME}]

runtime_path = "${PATH_TO_BINARY}"

更详细信息,请查阅 CRI-O 配置文档。

调度

Kubernetes v1.16 [beta]

通过为 RuntimeClass 指定 scheduling 字段,

你可以通过设置约束,确保运行该 RuntimeClass 的 Pod 被调度到支持该 RuntimeClass 的节点上。

如果未设置 scheduling,则假定所有节点均支持此 RuntimeClass 。

为了确保 pod 会被调度到支持指定运行时的 node 上,每个 node 需要设置一个通用的 label 用于被

runtimeclass.scheduling.nodeSelector 挑选。在 admission 阶段,RuntimeClass 的 nodeSelector 将会与

pod 的 nodeSelector 合并,取二者的交集。如果有冲突,pod 将会被拒绝。

如果 node 需要阻止某些需要特定 RuntimeClass 的 pod,可以在 tolerations 中指定。

与 nodeSelector 一样,tolerations 也在 admission 阶段与 pod 的 tolerations 合并,取二者的并集。

更多有关 node selector 和 tolerations 的配置信息,请查阅 将 Pod 分派到节点。

Pod 开销

Kubernetes v1.18 [beta]

你可以指定与运行 Pod 相关的 开销 资源。声明开销即允许集群(包括调度器)在决策 Pod 和资源时将其考虑在内。 若要使用 Pod 开销特性,你必须确保 PodOverhead 特性门控 处于启用状态(默认为启用状态)。

Pod 开销通过 RuntimeClass 的 overhead 字段定义。

通过使用这些字段,你可以指定使用该 RuntimeClass 运行 Pod 时的开销并确保 Kubernetes 将这些开销计算在内。

接下来

3.4 - 容器生命周期回调

这个页面描述了 kubelet 管理的容器如何使用容器生命周期回调框架, 藉由其管理生命周期中的事件触发,运行指定代码。

概述

类似于许多具有生命周期回调组件的编程语言框架,例如 Angular、Kubernetes 为容器提供了生命周期回调。 回调使容器能够了解其管理生命周期中的事件,并在执行相应的生命周期回调时运行在处理程序中实现的代码。

容器回调

有两个回调暴露给容器:

PostStart

这个回调在容器被创建之后立即被执行。 但是,不能保证回调会在容器入口点(ENTRYPOINT)之前执行。 没有参数传递给处理程序。

PreStop

在容器因 API 请求或者管理事件(诸如存活态探针、启动探针失败、资源抢占、资源竞争等)

而被终止之前,此回调会被调用。

如果容器已经处于已终止或者已完成状态,则对 preStop 回调的调用将失败。

在用来停止容器的 TERM 信号被发出之前,回调必须执行结束。

Pod 的终止宽限周期在 PreStop 回调被执行之前即开始计数,所以无论

回调函数的执行结果如何,容器最终都会在 Pod 的终止宽限期内被终止。

没有参数会被传递给处理程序。

有关终止行为的更详细描述,请参见 终止 Pod。

回调处理程序的实现

容器可以通过实现和注册该回调的处理程序来访问该回调。 针对容器,有两种类型的回调处理程序可供实现:

- Exec - 在容器的 cgroups 和名称空间中执行特定的命令(例如

pre-stop.sh)。 命令所消耗的资源计入容器的资源消耗。 - HTTP - 对容器上的特定端点执行 HTTP 请求。

回调处理程序执行

当调用容器生命周期管理回调时,Kubernetes 管理系统根据回调动作执行其处理程序,

httpGet 和 tcpSocket 在kubelet 进程执行,而 exec 则由容器内执行 。

回调处理程序调用在包含容器的 Pod 上下文中是同步的。

这意味着对于 PostStart 回调,容器入口点和回调异步触发。

但是,如果回调运行或挂起的时间太长,则容器无法达到 running 状态。

PreStop 回调并不会与停止容器的信号处理程序异步执行;回调必须在

可以发送信号之前完成执行。

如果 PreStop 回调在执行期间停滞不前,Pod 的阶段会变成 Terminating

并且一直处于该状态,直到其 terminationGracePeriodSeconds 耗尽为止,

这时 Pod 会被杀死。

这一宽限期是针对 PreStop 回调的执行时间及容器正常停止时间的总和而言的。

例如,如果 terminationGracePeriodSeconds 是 60,回调函数花了 55 秒钟

完成执行,而容器在收到信号之后花了 10 秒钟来正常结束,那么容器会在其

能够正常结束之前即被杀死,因为 terminationGracePeriodSeconds 的值

小于后面两件事情所花费的总时间(55+10)。

如果 PostStart 或 PreStop 回调失败,它会杀死容器。

用户应该使他们的回调处理程序尽可能的轻量级。 但也需要考虑长时间运行的命令也很有用的情况,比如在停止容器之前保存状态。

回调递送保证

回调的递送应该是 至少一次,这意味着对于任何给定的事件,

例如 PostStart 或 PreStop,回调可以被调用多次。

如何正确处理被多次调用的情况,是回调实现所要考虑的问题。

通常情况下,只会进行单次递送。 例如,如果 HTTP 回调接收器宕机,无法接收流量,则不会尝试重新发送。 然而,偶尔也会发生重复递送的可能。 例如,如果 kubelet 在发送回调的过程中重新启动,回调可能会在 kubelet 恢复后重新发送。

调试回调处理程序

回调处理程序的日志不会在 Pod 事件中公开。

如果处理程序由于某种原因失败,它将播放一个事件。

对于 PostStart,这是 FailedPostStartHook 事件,对于 PreStop,这是 FailedPreStopHook 事件。

要自己生成失败的 FailedPreStopHook 事件,请修改

lifecycle-events.yaml

文件将 postStart 命令更改为 ”badcommand“ 并应用它。

以下是通过运行 kubectl describe pod lifecycle-demo 后你看到的一些结果事件的示例输出:

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Scheduled 7s default-scheduler Successfully assigned default/lifecycle-demo to ip-XXX-XXX-XX-XX.us-east-2...

Normal Pulled 6s kubelet Successfully pulled image "nginx" in 229.604315ms

Normal Pulling 4s (x2 over 6s) kubelet Pulling image "nginx"

Normal Created 4s (x2 over 5s) kubelet Created container lifecycle-demo-container

Normal Started 4s (x2 over 5s) kubelet Started container lifecycle-demo-container

Warning FailedPostStartHook 4s (x2 over 5s) kubelet Exec lifecycle hook ([badcommand]) for Container "lifecycle-demo-container" in Pod "lifecycle-demo_default(30229739-9651-4e5a-9a32-a8f1688862db)" failed - error: command 'badcommand' exited with 126: , message: "OCI runtime exec failed: exec failed: container_linux.go:380: starting container process caused: exec: \"badcommand\": executable file not found in $PATH: unknown\r\n"

Normal Killing 4s (x2 over 5s) kubelet FailedPostStartHook

Normal Pulled 4s kubelet Successfully pulled image "nginx" in 215.66395ms

Warning BackOff 2s (x2 over 3s) kubelet Back-off restarting failed container

接下来

- 进一步了解容器环境

- 动手实践,为容器生命周期事件添加处理程序

4 - 工作负载

无论你的负载是单一组件还是由多个一同工作的组件构成,在 Kubernetes 中你 可以在一组 Pods 中运行它。 在 Kubernetes 中,Pod 代表的是集群上处于运行状态的一组 容器。

Kubernetes Pods 有确定的生命周期。 例如,当某 Pod 在你的集群中运行时,Pod 运行所在的 节点 出现致命错误时, 所有该节点上的 Pods 都会失败。Kubernetes 将这类失败视为最终状态: 即使该节点后来恢复正常运行,你也需要创建新的 Pod 来恢复应用。

不过,为了让用户的日子略微好过一些,你并不需要直接管理每个 Pod。 相反,你可以使用 负载资源 来替你管理一组 Pods。 这些资源配置 控制器 来确保合适类型的、处于运行状态的 Pod 个数是正确的,与你所指定的状态相一致。

Kubernetes 提供若干种内置的工作负载资源:

- Deployment 和

ReplicaSet

(替换原来的资源 ReplicationController)。

Deployment很适合用来管理你的集群上的无状态应用,Deployment中的所有Pod都是相互等价的,并且在需要的时候被换掉。 - StatefulSet

让你能够运行一个或者多个以某种方式跟踪应用状态的 Pods。

例如,如果你的负载会将数据作持久存储,你可以运行一个

StatefulSet,将每个Pod与某个PersistentVolume对应起来。你在StatefulSet中各个Pod内运行的代码可以将数据复制到同一StatefulSet中的其它Pod中以提高整体的服务可靠性。

- DaemonSet

定义提供节点本地支撑设施的

Pods。这些 Pods 可能对于你的集群的运维是 非常重要的,例如作为网络链接的辅助工具或者作为网络 插件 的一部分等等。每次你向集群中添加一个新节点时,如果该节点与某DaemonSet的规约匹配,则控制面会为该DaemonSet调度一个Pod到该新节点上运行。 - Job 和

CronJob。

定义一些一直运行到结束并停止的任务。

Job用来表达的是一次性的任务,而CronJob会根据其时间规划反复运行。

在庞大的 Kubernetes 生态系统中,你还可以找到一些提供额外操作的第三方

工作负载资源。通过使用

定制资源定义(CRD),

你可以添加第三方工作负载资源,以完成原本不是 Kubernetes 核心功能的工作。

例如,如果你希望运行一组 Pods,但要求所有 Pods 都可用时才执行操作

(比如针对某种高吞吐量的分布式任务),你可以实现一个能够满足这一需求

的扩展,并将其安装到集群中运行。

接下来

除了阅读了解每类资源外,你还可以了解与这些资源相关的任务:

- 使用 Deployment 运行一个无状态的应用

- 以单实例 或者多副本集合 的形式运行有状态的应用;

- 使用

CronJob运行自动化的任务

要了解 Kubernetes 将代码与配置分离的实现机制,可参阅 配置部分。

关于 Kubernetes 如何为应用管理 Pods,还有两个支撑概念能够提供相关背景信息:

- 垃圾收集机制负责在 对象的 属主资源 被删除时在集群中清理这些对象。

- Time-to-Live 控制器 会在 Job 结束之后的指定时间间隔之后删除它们。

一旦你的应用处于运行状态,你就可能想要以

Service

的形式使之可在互联网上访问;或者对于 Web 应用而言,使用

Ingress 资源将其暴露到互联网上。

4.1 - Pods

Pod 是可以在 Kubernetes 中创建和管理的、最小的可部署的计算单元。

Pod (就像在鲸鱼荚或者豌豆荚中)是一组(一个或多个) 容器; 这些容器共享存储、网络、以及怎样运行这些容器的声明。 Pod 中的内容总是并置(colocated)的并且一同调度,在共享的上下文中运行。 Pod 所建模的是特定于应用的“逻辑主机”,其中包含一个或多个应用容器, 这些容器是相对紧密的耦合在一起的。 在非云环境中,在相同的物理机或虚拟机上运行的应用类似于 在同一逻辑主机上运行的云应用。

除了应用容器,Pod 还可以包含在 Pod 启动期间运行的 Init 容器。 你也可以在集群中支持临时性容器 的情况下,为调试的目的注入临时性容器。

什么是 Pod?

Pod 的共享上下文包括一组 Linux 名字空间、控制组(cgroup)和可能一些其他的隔离 方面,即用来隔离 Docker 容器的技术。 在 Pod 的上下文中,每个独立的应用可能会进一步实施隔离。

就 Docker 概念的术语而言,Pod 类似于共享名字空间和文件系统卷的一组 Docker 容器。

使用 Pod

通常你不需要直接创建 Pod,甚至单实例 Pod。 相反,你会使用诸如 Deployment 或 Job 这类工作负载资源 来创建 Pod。如果 Pod 需要跟踪状态, 可以考虑 StatefulSet 资源。

Kubernetes 集群中的 Pod 主要有两种用法:

-

运行单个容器的 Pod。"每个 Pod 一个容器"模型是最常见的 Kubernetes 用例; 在这种情况下,可以将 Pod 看作单个容器的包装器,并且 Kubernetes 直接管理 Pod,而不是容器。

-

运行多个协同工作的容器的 Pod。 Pod 可能封装由多个紧密耦合且需要共享资源的共处容器组成的应用程序。 这些位于同一位置的容器可能形成单个内聚的服务单元 —— 一个容器将文件从共享卷提供给公众, 而另一个单独的“边车”(sidecar)容器则刷新或更新这些文件。 Pod 将这些容器和存储资源打包为一个可管理的实体。

说明: 将多个并置、同管的容器组织到一个 Pod 中是一种相对高级的使用场景。 只有在一些场景中,容器之间紧密关联时你才应该使用这种模式。

每个 Pod 都旨在运行给定应用程序的单个实例。如果希望横向扩展应用程序(例如,运行多个实例 以提供更多的资源),则应该使用多个 Pod,每个实例使用一个 Pod。 在 Kubernetes 中,这通常被称为 副本(Replication)。 通常使用一种工作负载资源及其控制器 来创建和管理一组 Pod 副本。

参见 Pod 和控制器以了解 Kubernetes 如何使用工作负载资源及其控制器以实现应用的扩缩和自动修复。

Pod 怎样管理多个容器

Pod 被设计成支持形成内聚服务单元的多个协作过程(形式为容器)。 Pod 中的容器被自动安排到集群中的同一物理机或虚拟机上,并可以一起进行调度。 容器之间可以共享资源和依赖、彼此通信、协调何时以及何种方式终止自身。

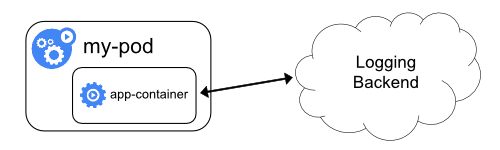

例如,你可能有一个容器,为共享卷中的文件提供 Web 服务器支持,以及一个单独的 “sidecar(挂斗)”容器负责从远端更新这些文件,如下图所示:

有些 Pod 具有 Init 容器 和 应用容器。 Init 容器会在启动应用容器之前运行并完成。

Pod 天生地为其成员容器提供了两种共享资源:网络和 存储。

使用 Pod

你很少在 Kubernetes 中直接创建一个个的 Pod,甚至是单实例(Singleton)的 Pod。 这是因为 Pod 被设计成了相对临时性的、用后即抛的一次性实体。 当 Pod 由你或者间接地由 控制器 创建时,它被调度在集群中的节点上运行。 Pod 会保持在该节点上运行,直到 Pod 结束执行、Pod 对象被删除、Pod 因资源不足而被 驱逐 或者节点失效为止。

当你为 Pod 对象创建清单时,要确保所指定的 Pod 名称是合法的 DNS 子域名。

Pod 和控制器

你可以使用工作负载资源来创建和管理多个 Pod。 资源的控制器能够处理副本的管理、上线,并在 Pod 失效时提供自愈能力。 例如,如果一个节点失败,控制器注意到该节点上的 Pod 已经停止工作, 就可以创建替换性的 Pod。调度器会将替身 Pod 调度到一个健康的节点执行。

下面是一些管理一个或者多个 Pod 的工作负载资源的示例:

Pod 模版

负载资源的控制器通常使用 Pod 模板(Pod Template) 来替你创建 Pod 并管理它们。

Pod 模板是包含在工作负载对象中的规范,用来创建 Pod。这类负载资源包括 Deployment、 Job 和 DaemonSets等。

工作负载的控制器会使用负载对象中的 PodTemplate 来生成实际的 Pod。

PodTemplate 是你用来运行应用时指定的负载资源的目标状态的一部分。

下面的示例是一个简单的 Job 的清单,其中的 template 指示启动一个容器。

该 Pod 中的容器会打印一条消息之后暂停。

apiVersion: batch/v1

kind: Job

metadata:

name: hello

spec:

template:

# 这里是 Pod 模版

spec:

containers:

- name: hello

image: busybox

command: ['sh', '-c', 'echo "Hello, Kubernetes!" && sleep 3600']

restartPolicy: OnFailure

# 以上为 Pod 模版

修改 Pod 模版或者切换到新的 Pod 模版都不会对已经存在的 Pod 起作用。 Pod 不会直接收到模版的更新。相反, 新的 Pod 会被创建出来,与更改后的 Pod 模版匹配。

例如,Deployment 控制器针对每个 Deployment 对象确保运行中的 Pod 与当前的 Pod 模版匹配。如果模版被更新,则 Deployment 必须删除现有的 Pod,基于更新后的模版 创建新的 Pod。每个工作负载资源都实现了自己的规则,用来处理对 Pod 模版的更新。

在节点上,kubelet并不直接监测 或管理与 Pod 模版相关的细节或模版的更新,这些细节都被抽象出来。 这种抽象和关注点分离简化了整个系统的语义,并且使得用户可以在不改变现有代码的 前提下就能扩展集群的行为。

Pod 更新与替换

正如前面章节所述,当某工作负载的 Pod 模板被改变时,控制器会基于更新的模板 创建新的 Pod 对象而不是对现有 Pod 执行更新或者修补操作。

Kubernetes 并不禁止你直接管理 Pod。对运行中的 Pod 的某些字段执行就地更新操作

还是可能的。不过,类似

patch 和

replace

这类更新操作有一些限制:

-

Pod 的绝大多数元数据都是不可变的。例如,你不可以改变其

namespace、name、uid或者creationTimestamp字段;generation字段是比较特别的,如果更新 该字段,只能增加字段取值而不能减少。 -

如果

metadata.deletionTimestamp已经被设置,则不可以向metadata.finalizers列表中添加新的条目。 -

Pod 更新不可以改变除

spec.containers[*].image、spec.initContainers[*].image、spec.activeDeadlineSeconds或spec.tolerations之外的字段。 对于spec.tolerations,你只被允许添加新的条目到其中。 -

在更新

spec.activeDeadlineSeconds字段时,以下两种更新操作是被允许的:- 如果该字段尚未设置,可以将其设置为一个正数;

- 如果该字段已经设置为一个正数,可以将其设置为一个更小的、非负的整数。

资源共享和通信

Pod 使它的成员容器间能够进行数据共享和通信。

Pod 中的存储

一个 Pod 可以设置一组共享的存储卷。 Pod 中的所有容器都可以访问该共享卷,从而允许这些容器共享数据。 卷还允许 Pod 中的持久数据保留下来,即使其中的容器需要重新启动。 有关 Kubernetes 如何在 Pod 中实现共享存储并将其提供给 Pod 的更多信息, 请参考卷。

Pod 联网

每个 Pod 都在每个地址族中获得一个唯一的 IP 地址。

Pod 中的每个容器共享网络名字空间,包括 IP 地址和网络端口。

Pod 内 的容器可以使用 localhost 互相通信。

当 Pod 中的容器与 Pod 之外 的实体通信时,它们必须协调如何使用共享的网络资源

(例如端口)。

在同一个 Pod 内,所有容器共享一个 IP 地址和端口空间,并且可以通过 localhost 发现对方。

他们也能通过如 SystemV 信号量或 POSIX 共享内存这类标准的进程间通信方式互相通信。

不同 Pod 中的容器的 IP 地址互不相同,没有

特殊配置 就不能使用 IPC 进行通信。

如果某容器希望与运行于其他 Pod 中的容器通信,可以通过 IP 联网的方式实现。

Pod 中的容器所看到的系统主机名与为 Pod 配置的 name 属性值相同。

网络部分提供了更多有关此内容的信息。

容器的特权模式

在 Linux 中,Pod 中的任何容器都可以使用容器规约中的

安全性上下文中的

privileged(Linux)参数启用特权模式。

这对于想要使用操作系统管理权能(Capabilities,如操纵网络堆栈和访问设备)

的容器很有用。

如果你的集群启用了 WindowsHostProcessContainers 特性,你可以使用 Pod 规约中安全上下文的

windowsOptions.hostProcess 参数来创建

Windows HostProcess Pod。

这些 Pod 中的所有容器都必须以 Windows HostProcess 容器方式运行。

HostProcess Pod 可以直接运行在主机上,它也能像 Linux 特权容器一样,用于执行管理任务。

静态 Pod

静态 Pod(Static Pod) 直接由特定节点上的 kubelet 守护进程管理,

不需要API 服务器看到它们。

尽管大多数 Pod 都是通过控制面(例如,Deployment)

来管理的,对于静态 Pod 而言,kubelet 直接监控每个 Pod,并在其失效时重启之。

静态 Pod 通常绑定到某个节点上的 kubelet。